Loi de probabilité — Wikipédia

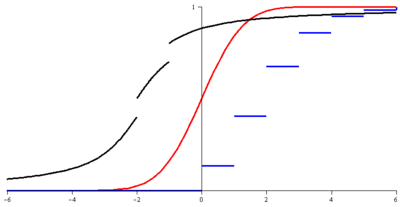

Représentation des fonctions de répartition de trois lois de probabilité :

|

En théorie des probabilités et en statistique, une loi de probabilité ou distribution de probabilité décrit le comportement aléatoire d'un phénomène dépendant du hasard. L'étude des phénomènes aléatoires a commencé avec l'étude des jeux de hasard. Jeux de dés, tirage de boules dans des urnes et jeu de pile ou face ont été des motivations pour comprendre et prévoir les expériences aléatoires. Ces premières approches sont des phénomènes discrets, c'est-à-dire dont le nombre de résultats possibles est fini ou infini dénombrable. Certaines questions ont cependant fait apparaître des lois à support infini non dénombrable ; par exemple, lorsque le nombre de tirages de pile ou face effectués tend vers l'infini, la distribution des fréquences avec lesquelles le côté pile apparaît s'approche d'une loi normale.

Des fluctuations ou de la variabilité sont présentes dans presque toute valeur qui peut être mesurée lors de l'observation d'un phénomène, quelle que soit sa nature ; de plus, presque toutes les mesures ont une part d'erreur intrinsèque. Les lois de probabilité permettent de modéliser ces incertitudes et de décrire des phénomènes physiques, biologiques, économiques, etc. Le domaine de la statistique permet de trouver des lois de probabilité adaptées aux phénomènes aléatoires.

Il existe beaucoup de lois de probabilité différentes. Parmi toutes ces lois, la loi normale a une importance particulière puisque, d'après le théorème central limite, elle approche le comportement asymptotique de nombreuses lois de probabilité.

Le concept de loi de probabilité se formalise mathématiquement à l'aide de la théorie de la mesure : une loi de probabilité est une mesure particulière, souvent vue comme la loi décrivant le comportement d'une variable aléatoire, discrète ou continue. Une mesure est une loi de probabilité si sa masse totale vaut 1. L'étude d'une variable aléatoire suivant une loi de probabilité discrète fait apparaître des calculs de sommes et de séries, alors que l'étude d'une variable aléatoire suivant une loi absolument continue fait apparaître des calculs d'intégrales. Des fonctions particulières permettent de caractériser les lois de probabilité, par exemple la fonction de répartition et la fonction caractéristique.

Définition informelle

[modifier | modifier le code]Une loi de probabilité décrit de manière théorique le caractère aléatoire d'une expérience dont le résultat dépend du hasard[1],[2]. La notion d'« expérience aléatoire » est dégagée pour désigner un processus réel de nature expérimentale, où le hasard intervient, avec des issues possibles bien identifiées[3]. Par exemple, le lancer d'un dé ordinaire (équilibré) est une expérience aléatoire : le résultat est un chiffre entre 1 et 6, et chaque chiffre a la même chance d'apparaître ; la loi de probabilité de cette expérience aléatoire est donc : les six chiffres sont équiprobables, de probabilité 1/6.

Historiquement, les lois de probabilité ont été étudiées dans les jeux de hasard : jeux de dés, jeux de cartes, etc. Les résultats possibles d'un tel phénomène sont en nombre fini, sa loi de probabilité est dite discrète. Donner la loi de probabilité revient à donner la liste des valeurs possibles avec leurs probabilités associées[4]. Elle est alors donnée sous forme de formule, de tableau de valeurs, d'arbre de probabilité ou de fonctions (qui seront détaillées dans les sections suivantes).

Dans un contexte plus général, c'est-à-dire dans le cas où le nombre de valeurs possibles du phénomène aléatoire n'est pas fini mais infini (dénombrable ou non), la loi de probabilité décrit toujours la répartition des chances pour des résultats possibles mais est caractérisée par des fonctions (densité de probabilité et fonction de répartition, entre autres) ou plus généralement par des mesures.

Historique

[modifier | modifier le code]

L'utilisation du hasard existe depuis l'Antiquité, notamment dans les jeux de hasard, les paris sur les risques des transports maritimes ou les rentes viagères[5]. Cependant, une des premières références connues à des calculs de probabilités est un calcul élémentaire sur la Divine Comédie qui n'apparaît qu'au XVe siècle pendant la Renaissance[6]. Les premiers traités forment le début de la théorie des probabilités, principalement basée sur des probabilités combinatoires. Les problèmes se posent ainsi, à propos de la durée d'un jeu de cartes :

« Sur la durée des parties que l'on joue en rabattant... On demande combien il y a à parier que la partie qui peut durer à l'infini sera finie en un certain nombre déterminé de coups au plus. »

— Essay, de Montmort, 1713[7].

On reconnaît ici la probabilité (« à parier ») qu'une variable (« la durée de la partie ») soit plus petite qu'une valeur (« certain nombre déterminé ») ; il s'agit de la fonction de répartition de la loi de probabilité de la durée d'une partie.

C'est dans la thèse de Nicolas Bernoulli, publiée en 1711, qu'apparaît pour la première fois la loi uniforme[8]. Certaines autres lois font alors leur apparition, comme la loi binomiale ou la loi normale, même si leurs approches ne sont pas complètement rigoureuses[8]. Par exemple, la loi normale est construite par Abraham de Moivre grâce à la courbe de Gauss par une approximation numérique[9]. Au XVIIIe siècle, d'autres idées liées aux lois de probabilité émergent également[8], comme l'espérance d'une variable aléatoire discrète avec Jean le Rond D'Alembert ou les probabilités conditionnelles avec Thomas Bayes. Quelques lois de probabilité continues sont énoncées dans un mémoire de Joseph-Louis Lagrange en 1770[8].

L'utilisation rigoureuse des lois de probabilité se développe à partir du XIXe siècle dans des sciences appliquées, telles que la biométrie avec Karl Pearson[10] ou la physique statistique avec Ludwig Boltzmann[11].

La définition formelle des mesures de probabilités commence en 1896 avec une publication d'Émile Borel[12] et se poursuit avec plusieurs autres mathématiciens tels que Henri-Léon Lebesgue, René Maurice Fréchet, Paul Lévy et notamment Andreï Kolmogorov qui formule les axiomes des probabilités en 1933.

Définition mathématique

[modifier | modifier le code]En théorie des probabilités, une loi de probabilité est une mesure dont la masse totale vaut 1. En particulier, cette mesure vérifie les trois axiomes des probabilités.

Définition[2] — Pour un espace mesurable, est une loi de probabilité, mesure de probabilité ou plus simplement probabilité si :

- est une application de dans [0,1] ;

- ;

- est -additive, c'est-à-dire pour toute famille finie ou dénombrable d'éléments deux à deux disjoints de :En particulier, .

Le triplet est appelé espace probabilisé. Une loi de probabilité est également appelée distribution de probabilité pour une étude plus appliquée[13].

Une manière usuelle d'expression d'une loi est l'utilisation d'une variable aléatoire puisque, pour toute loi de probabilité sur , il existe[14] une variable aléatoire définie sur un espace probabilisé (potentiellement différent de ) et de loi . Les lois les plus couramment étudiées en théorie des probabilités sont les lois à valeurs réelles ; elles peuvent être représentées à l'aide d'une variable aléatoire réelle par la définition suivante.

Définition[15] — Soit une variable aléatoire réelle sur l'espace probabilisé , c'est-à-dire une fonction mesurable .

La loi de probabilité de la variable aléatoire est la mesure de probabilité, notée , définie sur l'espace mesurable par :

pour tout borélien réel . Autrement dit, est la mesure image de par .

Ainsi, pour définir la loi d'une variable aléatoire, on transporte la loi de probabilité sur en une mesure sur .

La représentation d'une loi par une variable aléatoire n'est pas unique[16]. Autrement dit, deux variables aléatoires différentes, ou même définies sur des espaces différents, peuvent avoir la même loi. Deux variables aléatoires réelles et ont même loi si (en termes d'égalité de mesures). C'est-à-dire : pour tout . Le théorème suivant permet d'utiliser une autre caractérisation :

Théorème de transfert[14] (ou de transport[17]) — Soit une variable aléatoire réelle . Alors :

pour toute fonction telle qu'au moins une des deux intégrales ait un sens[18].

L'intégrale apparaissant dans le dernier terme est l'intégrale, au sens de la théorie de la mesure, de la fonction par rapport à la mesure . Cette intégrale prend la forme d'une somme dans le cas des lois discrètes.

Ainsi, deux variables aléatoires réelles et ont même loi si : pour toute fonction telle qu'au moins un des deux termes de l'égalité ait un sens.

Ce résultat est appelé law of the unconscious statistician (en) en anglais.

Loi multidimensionnelle

[modifier | modifier le code]

Intuitivement, une loi de probabilité est dite multidimensionnelle, ou n-dimensionnelle[19], si elle décrit plusieurs valeurs (aléatoires) d'un phénomène aléatoire. Par exemple lors du jet de deux dés, la loi de probabilité des deux résultats obtenus est une loi bidimensionnelle. Le caractère multidimensionnel apparaît ainsi lors du transfert, par une variable aléatoire, de l'espace probabilisé vers un espace numérique de dimension n. Dans l'exemple des deux dés, la dimension est n = 2 et l'espace est . La loi est également appelée loi jointe[20].

Un exemple important de loi multidimensionnelle est la loi de probabilité produit où et sont deux lois unidimensionnelles. Cette loi de probabilité est la loi d'un couple de variables aléatoires indépendantes[21], c'est le cas de l'exemple des deux dés.

Définition — Soit une variable aléatoire sur l'espace probabilisé , à valeurs dans muni de la tribu borélienne réelle produit . La loi de la variable aléatoire est la mesure de probabilité définie par pour tout :

La variable aléatoire est alors identifiée[22] à un vecteur aléatoire à n dimensions : . Le théorème de Cramer-Wold[23] assure que la loi (n-dimensionnelle) de ce vecteur aléatoire est entièrement déterminée par les lois (unidimensionnelles) de toutes les combinaisons linéaires de ses composantes : pour tous .

Cas d'une loi absolument continue

[modifier | modifier le code]Une loi bidimensionnelle (ou n-dimensionnelle) est dite[24] absolument continue sur si la loi est absolument continue par rapport à la mesure de Lebesgue sur , c'est-à-dire si la loi de la variable aléatoire correspondante s'écrit sous la forme :

- pour tout

Lois marginales

[modifier | modifier le code]Intuitivement, la loi marginale d'un vecteur aléatoire est la loi de probabilité d'une de ses composantes. Pour l'obtenir, on projette la loi sur l'espace unidimensionnel de la coordonnée recherchée. La loi de probabilité de la i-ème coordonnée d'un vecteur aléatoire est appelée la i-ème loi marginale[25]. La loi marginale de s'obtient par la formule :

- pour tout .

Les lois marginales d'une loi absolument continue s'expriment à l'aide de leurs densités marginales.

Loi conditionnelle

[modifier | modifier le code]

Intuitivement, une loi de probabilité conditionnelle permet de décrire le comportement aléatoire d'un phénomène lorsque l'on connaît une information sur ce processus. Autrement dit, la probabilité conditionnelle permet d'évaluer le degré de dépendance stochastique entre deux évènements[26]. Par exemple, lors d'un lancer de dés, la loi conditionnelle permet de donner la loi de la somme des résultats sachant que l'un des deux dés a donné un résultat d'au moins quatre.

Définition sur les évènements

[modifier | modifier le code]La probabilité conditionnelle se définit[27], de manière la plus intuitive, sur les évènements par la probabilité d'un évènement A conditionnellement à un autre événement B. Pour tout A et B de la tribu sous-jacente tels que :

La loi de probabilité[28] est utilisée dans les probabilités et statistique élémentaires, pour la formule des probabilités totales ou le théorème de Bayes par exemple.

Définition pour les variables aléatoires

[modifier | modifier le code]La probabilité conditionnelle est également définie pour les variables aléatoires. On étudie alors la loi d'une variable X conditionnellement à une variable Y. Lorsque , la loi de X sachant Y = y est définie par[28] :

Cependant, cette définition n'est pas valide si la loi de Y est absolument continue puisque , pour tout y. La définition suivante est valide pour tout couple de variables aléatoires.

Définition[29] — Soit un couple de variables aléatoires réelles. Il existe une loi de probabilité , appelée loi conditionnelle de sachant , ou sachant , définie par, pour toute fonction borélienne bornée :

La loi est également notée ou . L'égalité précédente est une égalité entre variables aléatoires[30].

Définition pour les tribus

[modifier | modifier le code]De manière plus générale, la loi de probabilité se définit à partir de l'espérance conditionnelle d'une variable aléatoire X sachant une tribu . Cette espérance conditionnelle est l'unique variable aléatoire -mesurable, notée et vérifiant[27] : pour toute Z, variable -mesurable. La loi conditionnelle est alors définie par[31] :

- où est la fonction indicatrice de .

Définition pour les lois absolument continues

[modifier | modifier le code]Dans le cas des lois absolument continues, il existe une densité conditionnelle d'une loi par rapport à l'autre, et inversement. Si est la densité de la loi bidimensionnelle, les deux densités conditionnelles sont alors données par[32] :

- et .

Ici, et sont les deux lois marginales de X et Y respectivement. En remplaçant les intégrales par des sommes, on obtient des formules similaires dans le cas où les lois marginales sont discrètes ou lorsque la loi marginale de X est discrète et celle de Y est absolument continue, ou inversement[33].

Loi à valeurs dans un espace de Banach

[modifier | modifier le code]Puisque est un espace de Banach, les lois à valeurs dans un espace de Banach généralisent les lois à valeurs réelles. La définition est alors similaire[34].

Définition — Soit une variable aléatoire sur l'espace probabilisé et à valeurs dans un espace de Banach muni de la tribu engendrée par les ensembles ouverts de . La loi de probabilité de la variable aléatoire est la mesure de probabilité définie sur l'espace mesurable par :

pour tout .

Pour obtenir de bonnes propriétés, il est courant de considérer des mesures de probabilités tendues, c'est-à-dire qui intuitivement sont concentrées sur un ensemble compact, et de supposer que l'espace de Banach est séparable[35].

Un exemple possible d'espace de Banach est l'espace des fonctions continues . Un processus stochastique est une famille de variables aléatoires indexées par un ensemble d'indices T. Une définition possible de la loi de probabilité d'un tel processus est la donnée des lois finies-dimensionnelles[36], c'est-à-dire la loi de probabilité multidimensionnelle des vecteurs lorsque . La loi peut alors être étendue par le théorème d'extension de Carathéodory pour le processus entier. Prenons l'exemple du mouvement brownien qui est à trajectoires continues, sa loi de probabilité est la mesure de Wiener[37], généralement notée W :

- , pour tout A sous-ensemble mesurable de .

Espace des lois de probabilité

[modifier | modifier le code]Une loi de probabilité est une mesure de masse totale unitaire. L'ensemble des lois de probabilité est donc un sous-espace de l'espace des mesures finies. Cet espace est souvent noté[38] ou pour les lois de probabilité réelles. Dans la suite de cette section, les propriétés de cet espace sont détaillées pour les lois de probabilité réelles ; elles sont cependant vraies sur les espaces de Banach.

On peut munir cet espace d'une topologie appelée la topologie faible[38]. Cette topologie définit donc une convergence faible des lois de probabilité : une suite de lois de probabilité converge faiblement vers une loi de probabilité si :

La convergence est notée[38] : . Cette convergence se répercute, par le théorème de transfert, sur les variables aléatoires de lois respectives ; la convergence de variables aléatoires est alors appelée convergence en loi (ou en distribution ou faible) et est notée ou . Si la convergence faible des variables aléatoires est souvent utilisée, elle ne concerne en fait que leur loi.

L'espace des lois de probabilité muni de cette topologie faible est[39] un espace métrique, complet et séparable (dans le cas d'un espace de Banach également séparable), ce qui en fait un espace polonais.

Propriétés

[modifier | modifier le code]Paramètres et familles

[modifier | modifier le code]Certaines lois sont regroupées par familles (appelées familles paramétriques de lois de probabilité) par rapport à certaines propriétés de leur densité ou de leur fonction de masse, ou suivant le nombre de paramètres qui les définissent.

Paramètres

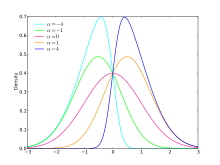

[modifier | modifier le code]Les paramètres dits de position[40] influent sur la tendance centrale de la loi de probabilité, c'est-à-dire la ou les valeurs autour desquelles la loi prend ses plus grandes valeurs. L'espérance, la médiane, le mode, les différents quantiles ou déciles en sont des exemples.

Les paramètres dits d'échelle[40] influent sur la dispersion ou l'« aplatissement » de la loi de probabilité. La variance (ou le moment d'ordre deux), l'écart type et l'écart interquartile en sont des exemples.

Les paramètres dits de forme[40] sont les autres paramètres liés aux lois de probabilité. La queue ou traîne d'une loi de probabilité réelle fait partie de sa forme. Les queues de gauche et de droite sont[41] respectivement des intervalles du type et . Une loi de probabilité est dite à queue lourde si la mesure de probabilité de la queue tend moins vite vers 0, pour x allant à l'infini, que celle de la loi normale[42]. Notamment, toute loi absolument continue, centrée, réduite dont la densité vérifie[43] :

est une loi à queues droite et gauche lourdes. L'asymétrie (ou moment d'ordre trois[44]) est un exemple de paramètre de forme, elle permet de rendre la queue de droite plus ou moins lourde[45]. Le kurtosis (ou moment d'ordre quatre[44]) permet de favoriser ou de défavoriser les valeurs proches de la moyenne de celles qui en sont éloignées. Une loi de probabilité est dite mésokurtique, leptokurtique ou platikurtique si son kurtosis est nul, positif ou négatif.

Familles de lois

[modifier | modifier le code]Une loi est dite de la famille exponentielle à un paramètre[46] si sa densité de probabilité ou sa fonction de masse ne dépend que d'un paramètre et est de la forme :

Cette famille regroupe beaucoup de lois classiques : loi normale, loi exponentielle, loi Gamma, loi du χ², loi bêta, loi de Bernoulli, loi de Poisson, etc.

Une loi est dite de la famille puissance à deux paramètres[46] et si sa densité est de la forme :

Loi directionnelle

[modifier | modifier le code]Lorsqu'une loi de probabilité multidimensionnelle représente la direction aléatoire d'un phénomène, elle est dite loi directionnelle. Elle est alors la loi d'un vecteur aléatoire unitaire d-dimensionnel où ou, de manière équivalente, c'est une loi de probabilité sur la sphère d-dimensionnelle. Une loi directionnelle d-dimensionnelle peut alors être représentée par un vecteur (d-1-dimensionnel) en coordonnées polaires. Les lois de von Mises et de Bingham en sont des exemples[a 1].

Moments

[modifier | modifier le code]S'il existe, le n-ième moment d'une loi de probabilité est défini par :

- .

Cette formule s'écrit[47] plus simplement dans le cas où la loi est définie à partir de la variable aléatoire .

Le premier moment, ou moment d'ordre 1, est également appelé l'espérance de la loi ; lorsque ce moment est nul, la loi est dite centrée. Le deuxième moment d'une loi centrée est également appelé la variance de la loi[48] ; lorsque ce moment vaut 1, la loi est dite réduite.

Certaines lois sont définies par un nombre fini de leurs moments : la loi de Poisson est complètement définie par son espérance[49], la loi normale est complètement définie par ses deux premiers moments[50] ; cependant, d'une manière générale, la collection de tous les moments d'une loi de probabilité ne suffit pas à caractériser cette dernière[51]. Certaines lois ne possèdent pas de moments, c'est le cas de la loi de Cauchy.

Entropie

[modifier | modifier le code]Les lois de probabilité permettent de représenter des phénomènes aléatoires. L'entropie de Shannon d'une loi de probabilité a été introduite en thermodynamique pour quantifier l'état de désordre moléculaire d'un système[52]. Le but est de mesurer par une fonction le manque d'information de la loi de probabilité[53]. L'entropie a d'abord été définie pour les lois discrètes puis étendue pour les lois absolument continues. Pour une loi discrète et une loi de densité , l'entropie H est définie respectivement par[52],[54] :

- et .

- La loi normale est celle d'entropie maximale parmi toutes les lois possibles ayant même moyenne et même écart-type[11].

- La loi géométrique est celle d'entropie maximale parmi toutes lois discrètes de même moyenne[11].

- La loi uniforme continue est celle d'entropie maximale parmi les lois à support borné.

- La loi exponentielle est celle d'entropie maximale parmi les lois portées par et ayant la même moyenne[11].

- Les lois de la famille puissance, comme celle de Zipf, sont d'entropie maximale parmi celles auxquelles on impose la valeur du logarithme d'une moyenne.

L'état d'entropie maximale est l'état le plus désordonné, le plus stable et le plus probable d'un système[53]. Ces lois sont donc les moins prévenues de toutes les lois compatibles avec les observations ou les contraintes, et donc les seules admissibles objectivement comme distributions de probabilités a priori. Cette propriété joue un grand rôle dans les méthodes bayésiennes.

Classification des lois de probabilité sur la droite réelle

[modifier | modifier le code]Les lois de probabilité les plus courantes dans les applications sont les lois dites discrètes et les lois dites absolument continues. Il existe cependant des lois de probabilité ni discrètes ni absolument continues.

Lois discrètes

[modifier | modifier le code]Définition

[modifier | modifier le code]

Une loi de probabilité est dite concentrée[49] ou portée sur un ensemble si . Une loi de probabilité est dite discrète[13],[15] s'il existe un ensemble fini ou dénombrable sur lequel elle est concentrée.

Un élément est appelé un atome d'une loi de probabilité si le singleton et si . L'ensemble des atomes d'une loi de probabilité est fini ou dénombrable. Plus généralement, cette propriété est valable pour toute mesure σ-finie. Pour une loi de probabilité réelle, l'ensemble de ses atomes est exactement l'ensemble des points de discontinuité de sa fonction de répartition[55] ; dans ce cas, la finitude ou la dénombrabilité de l'ensemble des atomes se retrouve à partir du fait que la fonction de répartition est bornée[56].

Un critère suffisant pour qu'une loi soit discrète est que soit fini ou dénombrable.

Si est discrète, alors elle est concentrée en particulier sur l'ensemble (fini ou dénombrable) de ses atomes[57]. Pour définir , il suffit alors de définir l'ensemble des couples[49] : , où est la fonction de masse de . On obtient ainsi :

- , pour tout ,

où est la mesure de Dirac[16],[24] au point .

Dans le cas où la loi de probabilité est définie à partir d'une variable aléatoire, les précédentes notions s'utilisent aussi pour cette variable aléatoire : une variable aléatoire est dite concentrée sur un ensemble , respectivement est dite discrète, si sa loi est concentrée sur , respectivement est discrète. De même, l'ensemble des atomes de est l'ensemble des atomes de .

Pour une variable aléatoire discrète , on obtient :

- , pour tout ,

où est la fonction de masse de , et la mesure de Dirac au point .

Pour une variable aléatoire discrète , le théorème de transfert s'exprime sous forme de sommes (ou de séries)[58] :

- , pour toute fonction positive ou nulle, ou telle que la série converge absolument.

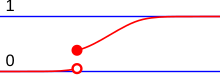

La fonction de répartition d'une loi discrète est constante par morceaux[49]. Une loi discrète peut être représentée par un diagramme en bâtons[13].

Exemples

[modifier | modifier le code]Voici une liste non exhaustive de lois de probabilité discrètes à support fini ou dénombrable.

Mesure de Dirac

[modifier | modifier le code]La mesure de Dirac est la plus simple des lois discrètes au sens où le support de la loi ne contient qu'une valeur[59]. Si une variable aléatoire est de loi de Dirac , alors vaut avec une probabilité égale à 1. Cette loi modélise un phénomène déterministe (non aléatoire) puisque le résultat de l'expérience est (presque sûrement) égal à la valeur connue .

Loi uniforme discrète

[modifier | modifier le code]La loi uniforme discrète modélise un phénomène aléatoire dont les résultats sont équiprobables, par exemple un lancer de dé. Si le support de la loi est l'ensemble à éléments distincts , alors cette loi est définie par :

Loi de Bernoulli

[modifier | modifier le code]La loi de Bernoulli correspond à une expérience à deux issues (succès–échec), généralement codées respectivement par les valeurs 1 et 0, lors d'une expérience à deux issues et dont la probabilité de succès est . Cette loi dépend d'un paramètre mesurant la probabilité de succès. Une variable aléatoire à valeurs dans possède une loi de Bernoulli si :

- et .

Son univers image est .

Loi binomiale

[modifier | modifier le code]C'est la loi du nombre de succès obtenus à l'issue de épreuves de Bernoulli indépendantes et de même paramètre , autrement dit c'est la loi de la somme de variables aléatoires indépendantes de loi de Bernoulli de même paramètre. Cette loi à support fini est définie par :

- , pour tout .

Son univers image est .

Distribution arithmétique

[modifier | modifier le code]C’est une distribution concentrée sur un ensemble du type , où .

Loi géométrique

[modifier | modifier le code]C'est la loi du numéro de l'épreuve amenant le premier succès lors d'une succession d'épreuves de Bernoulli indépendantes et de même paramètre . Elle peut ainsi modéliser le temps d'attente du premier succès dans une série d'épreuves de Bernoulli indépendantes à probabilité de succès . C'est l'unique loi discrète à posséder la propriété de perte de mémoire. Cette loi à support infini dénombrable est définie par :

- , pour tout .

Son univers image est .

Loi de Poisson

[modifier | modifier le code]La loi de Poisson est la loi qui décrit le comportement du nombre d'évènements se produisant dans un laps de temps fixé lorsque l’écart entre deux évènements successifs suit une loi exponentielle, ce qui est le cas dans la plupart des applications. Cette loi à support infini dénombrable dépend d'un paramètre . Si est une variable aléatoire suivant une loi de Poisson, alors :

- , pour tout .

Son univers image est .

Loi hypergéométrique

[modifier | modifier le code]La loi hypergéométrique est la loi suivie par le nombre de boules gagnantes extraites lors d'un tirage simultané de boules dans une urne contenant boules gagnantes et boules perdantes. Cette loi à support fini dépend de trois paramètres , et , et est définie par :

- , pour tout .

Lois absolument continues

[modifier | modifier le code]Définitions

[modifier | modifier le code]

Une loi de probabilité réelle est dite absolument continue[60] ou à densité[24] lorsqu'elle est absolument continue par rapport à la mesure de Lebesgue.

Si est absolument continue alors en vertu du théorème de Radon-Nikodym[61], elle possède une densité de probabilité par rapport à la mesure de Lebesgue, c'est-à-dire qu'il existe[24] une unique (à égalité Lebesgue-presque partout près) fonction mesurable positive telle que pour tout :

où est la fonction caractéristique du borélien . Cette densité de probabilité n'a pas toujours d'expression analytique (voir les exemples ci-dessous).

Lorsqu'une loi de probabilité absolument continue est définie à partir d'une variable aléatoire , la variable aléatoire est dite absolument continue[16] ou à densité et la densité de la loi est également appelée la densité de , elle est parfois notée .

Pour une variable aléatoire absolument continue , le théorème de transfert s'écrit[62] à l'aide d'une intégrale de Lebesgue[60], pour toute fonction intégrable par rapport à ou positive ou nulle :

- .

La fonction de répartition d'une loi absolument continue est localement absolument continue, c'est une propriété nécessaire et suffisante. Une loi absolument continue ne possède pas d'atome[63]. Toutefois, cette propriété, qui oppose les lois absolument continues aux lois discrètes, n'est pas caractéristique des lois absolument continues mais des lois continues (voir la section Lois singulières ci-dessous).

Les lois absolument continues sont parfois appelées plus simplement lois continues[64]. C'est un abus de langage dû au fait que dans la plupart des applications en statistique, les lois continues sont absolument continues[65], mais ce n'est pas vrai dans le cas général.

Exemples

[modifier | modifier le code]Loi uniforme

[modifier | modifier le code]La loi uniforme sur un intervalle indique, intuitivement, que toutes les valeurs de l'intervalle ont les mêmes chances d'apparaître. Plus formellement, chaque sous-intervalle a une probabilité égale à la mesure de Lebesgue de (multipliée par une constante) d'apparaître. La loi uniforme ne dépend que de l'intervalle, son support est compact et sa densité est donnée par :

- pour .

- sinon.

Loi exponentielle

[modifier | modifier le code]La loi exponentielle est la loi communément utilisée pour modéliser le temps de vie d'un phénomène puisque c'est l'unique loi absolument continue possédant la propriété de perte de mémoire. En ce sens elle est l'analogue continu de la loi géométrique. Cette loi à support semi-infini ne dépend que d'un paramètre (parfois appelé l'intensité), sa densité est donnée par, pour tout :

- .

Loi normale

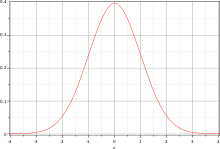

[modifier | modifier le code]La loi normale, ou loi gaussienne, est une loi centrale en théorie des probabilités et en statistique. Elle décrit le comportement des séries d'expériences aléatoires lorsque le nombre d'essais est très grand. C'est la loi limite dans le théorème central limite, elle est également l'unique loi stable de paramètre 2. La loi normale est caractérisée par sa moyenne (qui est également sa médiane) et par son écart-type, son support est la droite réelle. Sa densité est symétrique et sa forme est communément appelée la courbe de Gauss ou courbe en cloche :

Loi de Cauchy

[modifier | modifier le code]La loi de Cauchy est la loi stable de paramètre 1, ce qui lui donne de bonnes propriétés. Elle est cependant un exemple typique de loi n'admettant pas de moments, en particulier ni moyenne, ni variance. Son support est la droite réelle et sa densité est symétrique et définie par :

- .

La loi de la position d'un mouvement brownien plan au moment où celui-ci atteint la droite est une loi de Cauchy[a 2].

Loi de Tukey-lambda

[modifier | modifier le code]La loi de Tukey-lambda est une loi absolument continue, elle possède donc une densité de probabilité mais cette dernière n'a pas d'expression analytique. Cette loi dépend d'un paramètre, son support est soit un intervalle borné centré à l'origine, soit la droite réelle (en fonction du paramètre). La loi de Tuckey-lambda est définie à partir de sa fonction quantile (voir section Autres caractérisations ci-dessous) :

- .

Lois singulières

[modifier | modifier le code]Définition

[modifier | modifier le code]Une loi de probabilité est dite continue ou diffuse[55] lorsqu'elle ne possède pas d'atome.

En particulier, les lois absolument continues sont continues, la réciproque n'est cependant pas vraie. La fonction de répartition d'une loi de probabilité réelle continue est continue[55], c'est une propriété nécessaire et suffisante.

Une loi de probabilité est dite singulière lorsqu'elle est continue mais pas absolument continue. C'est-à-dire qu'une loi singulière ne possède ni atome, ni densité.

Ces notions se disent également pour les lois de probabilité définies à partir de variables aléatoires : une variable aléatoire est continue (ou diffuse), respectivement singulière, lorsque sa loi de probabilité associée est continue (ou diffuse), respectivement singulière.

Exemple

[modifier | modifier le code]

C'est une loi singulière. Elle est définie à partir de l'ensemble de Cantor : . Lorsque sont des variables indépendantes et identiquement distribuées de loi uniforme discrète sur , alors

est une variable aléatoire de loi de Cantor[66]. Cette loi de probabilité[67] s'écrit sous la forme , c'est la loi uniforme sur l'ensemble de Cantor. Sa fonction de répartition est l'escalier de Cantor, elle est dérivable presque partout et de dérivée nulle presque partout[66].

Dans les applications, il est rare que les lois continues contiennent une partie singulière[65]. L'ensemble de Cantor apparaît toutefois dans certains exemples bien connus : l'ensemble des zéros du mouvement brownien est un ensemble de type Cantor.

Autres cas

[modifier | modifier le code]Il existe des lois de probabilité qui ne sont ni discrètes, ni absolument continues, ni singulières, elles sont parfois appelées lois mixtes[68],[69].

D'un point de vue plus général, toute loi de probabilité peut se décomposer[65],[56] en une combinaison linéaire d'une loi continue et d'une loi discrète . De plus le théorème de décomposition de Lebesgue appliqué[65] à indique que cette loi continue se décompose en une combinaison linéaire de deux lois continues, l'une est absolument continue par rapport à la mesure de Lebesgue et l'autre est singulière, étrangère à la mesure de Lebesgue. La décomposition s'écrit donc[70] :

avec et . La présence de assure que .

La loi de probabilité réelle suivante est un exemple de loi mixte obtenue en mélangeant une loi discrète, définie par ses atomes et sa fonction de masse , avec une loi absolument continue[65] de densité :

où . Sa fonction de répartition est une fonction continue par morceaux[71], mais pas constante par morceaux (ce qui est le cas des fonctions de répartition des lois discrètes).

Intuitivement, cela correspond à un phénomène aléatoire dont la loi est absolument continue. Cependant, l'appareil de mesure ne peut mesurer les données qu'à partir d'un certain seuil c. Toutes les mesures non détectées par l'appareil seront assignées à 0, ainsi la loi est nulle sur toute partie « plus petite » que c alors qu'un saut apparaît au singleton c. Les mesures suivent la loi absolument continue pour les valeurs plus grandes que c[68]. Dans cet exemple la fonction de répartition est discontinue en c.

Caractérisations d'une loi de probabilité

[modifier | modifier le code]Il existe plusieurs fonctions à variables réelles ou complexes qui déterminent de manière unique les lois de probabilité. Les propriétés de certaines de ces fonctions permettent de déduire des propriétés pour les lois comme le calcul des moments ou une expression de la convergence en loi.

À l'aide de la fonction de répartition

[modifier | modifier le code]

D'après le lemme de classe monotone, les ensembles , appelés pavés ou rectangles, engendrent[72] la tribu borélienne réelle et sont stables par intersection finie, il suffit alors de définir une loi de probabilité sur les pavés. On suppose que la loi de probabilité est réelle, c'est-à-dire .

La fonction de répartition d'une loi de probabilité réelle, notée par , est[73] la fonction définie par, pour tout :

Une loi de probabilité est caractérisée par sa fonction de répartition, c'est-à-dire que deux lois de probabilité sont égales si et seulement si leurs fonctions de répartitions sont égales[74].

Plus généralement, toute fonction croissante, continue à droite et vérifiant : et est la fonction de répartition d'une unique[75] loi de probabilité sur . La loi de probabilité définie à partir d'une fonction de répartition est appelée mesure de Lebesgue-Stieltjes[74].

Un des avantages de la fonction est qu'elle est bien définie pour toute loi de probabilité[75]. Cependant, elle n'a pas toujours d'expression explicite, un exemple étant la fonction de répartition de la loi normale. La fonction de répartition permet parfois des calculs de lois aisés (loi du maximum ou du minimum d'un échantillon, par exemple) et fournit un critère commode[76] de convergence des lois de probabilité via le théorème porte-manteau.

À l'aide de la fonction caractéristique

[modifier | modifier le code]

On appelle fonction caractéristique d'une loi de probabilité , et l'on note , la « symétrie » de la transformée de Fourier de . Pour tout :

Suivant la définition de la transformée de Fourier, la fonction caractéristique est sa symétrique ou non[77]. Comme son nom l'indique, la fonction caractéristique détermine la loi de manière unique[78], c'est-à-dire que deux lois de probabilité sont égales si et seulement si leurs fonctions caractéristiques sont égales.

Un des avantages de la fonction caractéristique est qu'elle existe pour toute loi de probabilité[76],[77]. De plus, en utilisant la formule d'inversion de la transformée de Fourier[79], la loi de probabilité s'obtient à partir de la fonction caractéristique. La représentation des lois par la fonction caractéristique permet également de caractériser[80] la convergence des lois de probabilité via le théorème porte-manteau.

Dans le cas où la loi de probabilité est définie à partir d'une variable aléatoire , d'après le théorème de transfert, pour tout :

À l'aide de la fonction génératrice des moments

[modifier | modifier le code]

La fonction génératrice des moments d'une loi de probabilité , notée , est la « symétrie » de la transformée de Laplace de [66],[81]. Lorsque la fonction est intégrable par rapport à la mesure , pour tout :

La fonction génératrice des moments détermine la loi de probabilité de manière unique si cette fonction existe sur un intervalle contenant l'origine[76].

Un des avantages de cette fonction génératrice des moments est qu'elle permet de retrouver les moments de la loi de probabilité par les dérivées[81]. Pour tout , la -ième dérivée de la fonction génératrice des moments en 0 est le moment d'ordre de la loi de probabilité :

- .

La représentation des lois par la fonction génératrice des moments permet également de caractériser[76] la convergence des lois de probabilité via le théorème porte-manteau.

Dans le cas où la loi de probabilité est définie à partir d'une variable aléatoire , d'après le théorème de transfert, pour tout

French

French Deutsch

Deutsch

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]{\stackrel {\text{déf.}}{=}}\int _{\Omega }\varphi {\big (}X(\omega ){\big )}\mathbb {P} (\mathrm {d} \omega )=\int _{\mathbb {R} }\varphi (x)\mathbb {P} _{X}(\mathrm {d} x),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c4ad97bc026c84c768efe3c24a1fa90be1477713)

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]=\mathbb {E} \left[\varphi (Y)\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/885e7731a6347edc000195e769b173b3999cde23)

![{\displaystyle \mathbb {E} \left[\varphi (X)|Y\right]=\int \varphi (x)\mathbb {P} _{X|Y}(\mathrm {d} x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7eaf8a0e5f85539c530ae8654d99a7c00e03091c)

![{\displaystyle \mathbb {E} \left[X|{\mathcal {G}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2b047bb458622f35497bd0b378b3b1d82ec3c19a)

![{\displaystyle \mathbb {E} \left[Z\mathbb {E} (X|{\mathcal {G}})\right]=\mathbb {E} \left[ZX\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b4a68f01eae65f27c2b7b93da93f785365810180)

![{\displaystyle \left]-\infty ,x\right[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d1fe7a3c2bec379b123b3abe379a16729cabb9a9)

![{\displaystyle m_{n}=\mathbb {E} [X^{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/91cde357ac7466638096542ae55ceadddfd0bed6)

![{\displaystyle \{(\omega ,p(\omega ))\in \Omega _{a}\times ]0,1]\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/db8be31292fb88ffd029900198d992475308baa6)

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]=\sum _{x\in \mathbb {R} _{a}}\varphi (x)\ p_{X}(x)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ba4e2a34cd458757b0c23ff0fb778c3785aa9a4a)

![{\displaystyle p\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33c3a52aa7b2d00227e85c641cca67e85583c43c)

![{\displaystyle \mathbb {E} \left[\varphi (X)\right]=\int _{\mathbb {R} }\varphi (x)f_{X}(x)\,\mathrm {d} x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3426601fcb58528af38fe8263c952f8751b12976)

![{\displaystyle \left[c,d\right]\subset \left[a,b\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5ae9069496f00ddb9ada019064530383bfc8abc7)

![{\displaystyle \left[c,d\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a1d8fbbc9f73f14f49a31914ad74c9e36a20a12)

![{\displaystyle x\in \left[a,b\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7c4dd3adabf0430c82fd37cb45576a1df8c60002)

![{\displaystyle \alpha ,\beta ,\gamma \in \left[0,1\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8e63b30e07aaa958969a4ef3a3f5dd95d6476848)

![{\displaystyle \alpha \in \left]0,1\right[}](https://wikimedia.org/api/rest_v1/media/math/render/svg/52e48c2c2556c120c6d8d07d20f24a778ef8c8f4)

![{\displaystyle \left]-\infty ,x\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8de33d15a9fefbd6eafe1a3db13a4439dacf0859)

![{\displaystyle F(x)=\mathbb {P} {\big (}\left]-\infty ,x\right]{\big )}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f4231eca481e0de76f53ee43bb3bf705e87a5898)

![{\displaystyle \Phi _{X}(t)=\int _{\mathbb {R} }\mathrm {e} ^{\mathrm {i} tx}\,\mathbb {P} _{X}(\mathrm {d} x)=\int _{\Omega }\mathrm {e} ^{\mathrm {i} tX(\omega )}\,\mathbb {P} (\mathrm {d} \omega )=\mathbb {E} \left[\mathrm {e} ^{\mathrm {i} tX}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d8ab30c7b612196a03feaf60e34456621665846e)