História da física – Wikipédia, a enciclopédia livre

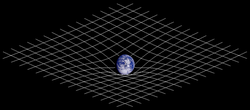

| Física |

|---|

|

| Curvatura Espaço-Tempo |

Pode-se traçar a história da Física a partir do momento em que a humanidade começou a ver e analisar os fenômenos naturais de modo racional, abandonando explicações místicas ou divinas. As primeiras tentativas racionais de explicação da Natureza vieram dos gregos antigos. Antes disso, fenômenos naturais e suas consequências eram explicados por deuses e deusas; Apolo, em sua carruagem, carregava a esfera brilhante, o Sol, de leste para oeste, todos os dias. A Filosofia Natural, como era conhecida a Física até tempos mais modernos, confundia-se com a Química e com certos aspectos da Matemática e Biologia, e pode ser considerada a disciplina acadêmica mais antiga, se for considerada a sua presença dentro da Astronomia.

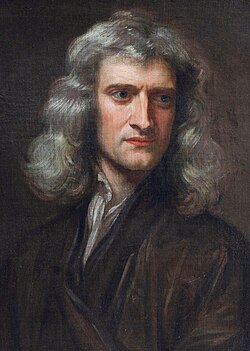

Após ter visto um momento de esplendor na Grécia Antiga, tendo como nome principal Aristóteles, a Física entrou em declínio na Idade Média, tendo revivido apenas durante o Renascimento, durante a Revolução Científica. Galileu Galilei é considerado o primeiro Físico em seu sentido moderno, adotando a Matemática como ferramenta principal. Galileu é um dos primeiros a descrever o real objetivo de um cientista; sua função é apenas descrever os fenômenos em vez de tentar explicá-los. Já dotado de um método científico, a Física teve uma notável evolução com Isaac Newton, que realizou a primeira grande unificação da Física ao unir Céus e Terra sob as mesmas leis da Física, a gravitação universal.

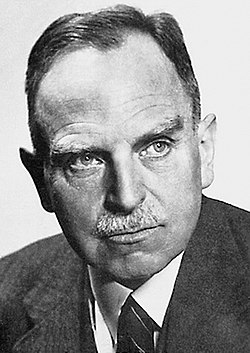

Nos séculos XVIII e XIX surgiram os fundamentos da termodinâmica e do eletromagnetismo, destacando-se Rudolf Clausius, James Prescott Joule e Michael Faraday. James Clerk Maxwell realizou outra grande unificação da Física ao fundir eletricidade e magnetismo sob as mesmas descrições matemáticas, sendo que toda a Óptica pode ser derivada da teoria eletromagnética de Maxwell. No final do século XIX pensava-se que todos os fenômenos físicos poderiam ser explicados dentro das teorias correntes. Entretanto, certos "fenômenos rebeldes" fugiam do alcance dos cientistas. No início do século XX, ao tentar explicar matematicamente a radiação de corpo negro, Max Planck introduziu o conceito de quantum de energia. Em 1905, Albert Einstein apresentou, sob a forma de cinco artigos, as base da Relatividade e da Mecânica Quântica. Tais "fenômenos rebeldes" finalmente foram explicados, mas a ontologia determinista estrita e pontual, característica da mecânica newtoniana, foi abalada seriamente, que foi agravada após a publicação do Princípio da Incerteza de Werner Heisenberg e do princípio da complementaridade de Niels Bohr.

Desde então, a Física preocupa-se em explicar, sob o ponto de vista da Física Moderna, a natureza das quatro forças fundamentais da Natureza. O Modelo Padrão, apresentado na década de 70, descreve três das quatro forças. Trabalhos dentro do Grande Colisor de Hádrons (LHC), no CERN, e no Fermilab, procuram confirmar a existência do bóson de Higgs, a única partícula prevista pelo Modelo Padrão ainda não descoberta. Entretanto, a gravidade ainda carece de uma explicação teórico-experimental enraizada pela Física Moderna e é ainda um grande problema em aberto da Física.

Antiguidade

[editar | editar código-fonte]

As pessoas desde a Antiguidade sempre prestaram atenção nas regularidades da Natureza;[1] o Sol nasce todo dia; um ciclo lunar é completado em aproximadamente 28 dias, praticamente o mesmo período de um ciclo menstrual; as estrelas ocupam a mesma posição no céu em um determinado momento a cada ano, um objeto sempre cai quando não é apoiado; as quatro estações do ano sempre estão ordenadas e se repetem anualmente.[2]

Esta ordenação da Natureza precisava de explicações satisfatórias. Inicialmente, os povos antigos atribuíam tais fatos à mitologia e à metafísica; deuses e deusas que controlavam o mundo. Na Grécia Antiga, Gaia era a deusa Terra e Zeus controlava o poder dos relâmpagos. Apolo, com a sua carruagem flamejante do Sol, cruzava os céus uma vez por dia.

Basicamente, "Física" é uma tentativa de se obter explicações racionais sobre o mundo real, em contraste com explicações metafísicas, mitológicas, religiosas ou mágicas.[3] Tomando Física com base nesta definição, os povos antigos começaram a construí-la em diferentes partes do mundo em diferentes épocas, com propósitos e ênfases diferentes.[3] O povo maia, no século I a.C, já havia desenvolvido um calendário; conheciam a duração de um ano com uma precisão de seis segundos. Também conheciam com bastante precisão os movimentos do Sol e dos planetas[4] e desenvolveram a noção de zero antes dos europeus.[5] Os indianos também haviam desenvolvido a noção de zero, que foi transmitido ao mundo árabe. Também refletiam sobre questões físicas desde o III milênio antes de Cristo.[6] Entre o IX e o VI século a.C. os filósofos indianos já defendiam o heliocentrismo e o atomismo.[6] Na Grécia Antiga, Tales de Mileto foi historicamente o primeiro filósofo ocidental a recusar explicações sobrenaturais, religiosas ou mitológicas para os fenômenos naturais, defendendo que todo evento tem uma causa natural.[7] No século IV a.C., os chineses já haviam enunciado o que é conhecido hoje como a Primeira Lei de Newton.[4]

Grécia Antiga

[editar | editar código-fonte]

Busto por Lísipo, Museu Nacional Romano

As primeiras tentativas do Ocidente em prover explicações racionais para os funcionamentos da Natureza vieram com os gregos, por volta do século VII a.C..[8] Pitágoras e seus seguidores, no século VI a.C., acreditavam que todo o sistema numérico era dividido em elementos finitos, uma ideia precursora do atomismo.[9] Os gregos Leucipo, Demócrito e Epicuro, nos séculos V a III a.C., impulsionaram a ideia de que a matéria era dividida em "átomos" extremamente pequenos, com diferentes materiais sendo formados de diferentes átomos e suas combinações.[10] Aristarco de Samos, no século III a.C., foi um dos primeiros gregos a propor o heliocentrismo,[11] embora o paradigma dominante fosse geocentrista.[12] Aristarco também tentou calcular o tamanho relativo da Terra, da Lua e do Sol.[11]

Entretanto, os gregos não estavam preocupados com a experimentação. Todas as explicações racionais do mundo eram derivados de um pequeno número de princípios filosóficos;[13] boas argumentações e um pouco de lógica se sobrepunham à comprovações empíricas, deixada para "artesãos".[14]

Aristóteles é descrito com frequência como sendo o grego que proveu as explicações mais compreensivas dentro destes princípios filosóficos. Ele acreditava na existência de quatro elementos básicos, a terra, a água, o ar e o fogo. Cada um tinha o seu lugar natural no Universo, determinado pelo seu peso. A terra é pesada e tenderia a permanecer no centro do Universo, a água tenderia a permanecer acima da terra e o ar, por sua vez, tenderia a permanecer na superfície terrestre. O fogo tenderia a escapar do centro do Universo.[15] Haveria ainda um quinto elemento, perfeito, que não teria peso. As estrelas seriam formadas por esse quinto elemento, o éter.[15]

Em seu livro, Física, Aristóteles descreveu o movimento de um corpo. Um corpo manteria seu estado de movimento apenas se estivesse em contato com o seu "movedor". Caso contrário, a tendência de um corpo seria parar. Aristóteles explicou que o movimento de uma flecha após ser lançada seria causada pela "impulsão do ar", uma tendência natural do ar fechar o "vácuo" formado pela flecha em seu rastro, já que, segundo Aristóteles, a "Natureza abomina qualquer forma de vácuo".[16] No caso dos objetos constituídos por éter, para Aristóteles, bastaria apenas um "lançamento inicial" para pôr tais objetos em movimento, e esse movimento seria perpétuo, pois objetos formados por éter não teriam peso e, portanto, não teriam a necessidade de um "movedor".[16]

Os gregos fizeram muitos esforços para prover explicações racionais sobre os movimentos dos planetas, do Sol, da Lua e das estrelas. Eudoxo de Cnido, no século IV a.C., foi aparentemente o primeiro grego a prover observações quantitativas sobre o movimento dos astros usando descrições matemáticas. Ele desenvolveu um sistema de esferas, notando a periodicidade dos movimentos dos astros. As esferas eram centradas na Terra, mas seus eixos de rotação eram centradas em esferas exteriores. Assim, Eudoxo elaborou um sistema de esferas concêntricas, e cada esfera estava ligada a um planeta.[12] Isto encaixava na crença dos gregos de que o círculo é o objeto geométrico mais perfeito.[17] Apolônio de Perga aperfeiçoou o sistema de esferas no século III a.C.; cada planeta estava fixada a uma pequena esfera, que por sua vez estava fixada em uma esfera maior, que completava uma volta a cada dia. Estas pequenas esferas ficaram conhecidas como epiciclos e explicavam o movimento retrógrado aparente dos planetas no céu para um observador da Terra.[4]

O sistema esférico dos astros foi se complexificando com o aumento da precisão matemática. Hiparco, no século II a.C., utilizou registros gregos e babilônicos para prover dados mais precisos, e Ptolomeu, no mesmo século, já havia construído um sistema de esferas contendo mais de 80 elementos para explicar toda a periodicidade dos astros no céu, todos descritos em seu livro Almagesto.[18] Eratóstenes deduziu que a Terra era uma esfera e calculou apuradamente sua circunferência usando sombras de bastões fincados verticalmente para comparar os ângulos, ou seja, o tamanho da sombra projetada no chão pelo bastão vertical, entre dois pontos bastante separados na superfície da Terra.[19] Arquimedes é considerado o fundador da hidrostática, da estática e formulou as leis da alavanca. Formulou os princípios do empuxo em fluidos, conhecidos como Princípios de Arquimedes. Arquimedes também inventou o parafuso de Arquimedes, uma máquina constituída de um parafuso e de um tubo, capaz de bombear água para níveis mais elevados.[20]

Idade Média e filosofia natural islâmica

[editar | editar código-fonte]

Final do século XIV

Com a queda do Império Romano no século V, a maior parte da literatura grega se perdeu assim que a Europa entrou num período conhecido como a Idade Média, onde a obtenção do conhecimento e da própria educação era árduo de se obter devido às catástrofes que havia ocorrido no declínio do Império Romano.

Entretanto, o conhecimento grego não foi totalmente perdido. Todo esse conhecimento, que havia migrado para o Oriente Médio e Egito, foi traduzido para o árabe pelas pessoas que viviam nestas regiões. Os árabes não somente mantiveram o conhecimento grego vivo, como o enriqueceram.[21] As leis da refração já haviam sido enunciadas pelos persas. Os árabes também traduziram trabalhos indianos e começaram a usar numerais e a álgebra.[22] A noção de zero foi levada para a Europa pelos árabes. Al-Battani calculou a precessão dos equinócios com maior precisão do que o grego Ptolomeu. Mohammed al-Fazari desenvolveu o astrolábio,[23] enquanto que al-Khwarizmi emprestou seu nome para que conhecemos atualmente como algarismo.[24]

No século XII, com a reconquista dos territórios árabes na Europa, teve início a tradução da literatura árabe e grega para o latim,[25] e a Europa Medieval redescobriu, assim, o conhecimento grego juntamente com novos conhecimentos árabes.[25] A intelectualidade na Europa durante a "Idade das Trevas" manteve-se preocupada com a cópia manuscrita de livros sagrados.[26] Em outras palavras, a educação estava em torno da Igreja Católica.[26] Com o passar dos séculos e com a "avalanche" de conhecimentos redescobertos, escolas começaram a se formar adjacentes às igrejas e catedrais. Tais escolas evoluíram para as primeiras universidades medievais por volta do século XIII.[27] As universidades inglesas de Cambridge e de Oxford surgiram nesta época.[28] Com o advento de universidades associadas à Igreja, outras universidades foram fundadas por governos de cidades e Estados.[4] O trabalho realizado dentro destas universidades medievais contribuiu muito para a evolução do conhecimento científico que se seguiria séculos depois.[29]

Na primeira metade do século XIV, ressurge a teoria do ímpeto, que já havia sido iniciada por Hiparco e impulsionada por João Filopono, radicalmente modificada pelo persa Avicena e consagrada pelo francês Jean Buridan.[30] Um projétil após ter sido lançado tem seu movimento continuado devido a algo interno, chamado "ímpeto", doado pelo lançador no momento do tiro. O "ímpeto" se perpetuaria se não houvesse a "tendência natural de cair ao chão" e se não houvesse contato com outros objetos. Um objeto com mais peso teria mais "ímpeto" do que um objeto mais leve, considerando-se a mesma velocidade. Esta maneira de pensar, ainda similar à "Física" de Aristóteles, tornou-se um antecessor às concepções de inércia, momento linear e aceleração.[31]

O inglês Guilherme de Ockham opôs-se à teoria do ímpeto e afirmou que não se pode diferenciar qual o objeto seria o projétil, o objeto lançado ou o lançador. Segundo ele, não podendo se afirmar qual é o projétil, não se pode afirmar nenhuma conclusão sobre "ímpeto".[32] Além disso, Ockham, um grande lógico, criou a chamada "Navalha de Ockham". Segundo este princípio, a melhor explicação para o funcionamento da Natureza é aquela que pode descrever o fenômeno nos seus princípios mais fundamentais. Outras descrições mais elaboradas são "descartadas".[32] Robert Grosseteste e Roger Bacon realizaram importantes trabalhos experimentais sobre óptica, nos séculos XII e XIII.[33]

Com o advento da peste negra, novamente a Europa caiu em um período onde se teve poucas produções científicas, encerrando-se apenas com a publicação de De revolutionibus orbium coelestium, de Nicolau Copérnico, trazendo o heliocentrismo novamente ao centro das atenções.[34]

Índia e China

[editar | editar código-fonte]

Tradições físicas e matemáticas importantes também existiam nas antigas ciências chinesas e indianas. Na filosofia indiana, Kanada foi o primeiro a desenvolver sistematicamente uma teoria do atomismo no século VI a.C.,[35] e foi mais elaborada pelos budistas e atomistas Dharmakirti e Dignaga durante o primeiro milênio d.C..[35] Pakudha Kaccayana, um filósofo indiano e contemporâneo de Gautama Buda do século VI a.C., também havia proposto ideias sobre a constituição atômica do mundo material. Estes filósofos acreditavam que outros elementos (excepto o éter) eram fisicamente palpáveis e, portanto, constituídos de minúsculas partículas de matéria. A última minúscula partícula de matéria que não pode ser subdividida, foi denominado Parmanu. O conceito indiano do átomo foi desenvolvido de forma independente e antes do desenvolvimento da ideia no mundo greco-romano. Estes filósofos consideraram o átomo ser indestrutível e, portanto, eterno. Os budistas pensara nos átomos como sendo objetos minúsculos incapazes de serem vistos a olho nu, que vem a ser e desaparecer em um instante. A escola Vaisheshika de filósofos acreditavam que um átomo era um mero ponto no espaço. Teorias indianas sobre o átomo são extremamente abstratas e enredadas em filosofia, pois foram baseadas na lógica e não na experiência pessoal ou experimentação. Na astronomia indiana, Aryabhatiya de Aryabhata (499 d.C. propôs a rotação da Terra, enquanto Nilakantha Somayaji (1444-1544) da escola Kerala de astronomia e matemática propôs um modelo semi-heliocêntrico que se assemelha ao sistema atual.

O estudo do magnetismo na China antiga remonta ao século IV a.C.. A principal contribuição para esse campo foi Shen Kuo (1031-1095), um cientista sábio e estadista que foi o primeiro a descrever a bússola com uma agulha magnética utilizada para navegação, como bem como descobrir o conceito de norte verdadeiro. Em óptica, Shen Kuo independentemente desenvolveu uma câmera obscura.[36]

Renascimento e o desenvolvimento do método científico

[editar | editar código-fonte]

Por Justus Sustermans, 1636

O Renascimento do conhecimento e da aprendizagem na Europa, que se seguiu à redescoberta dos conhecimentos gregos e árabes, afetou toda a sociedade europeia.[37]

Em 1541, Nicolau Copérnico publica o livro De revolutionibus orbium coelestium, que marca o início da astronomia moderna.[34] Neste livro, Copérnico defende o heliocentrismo e o suporta matematicamente.[34] A partir do século XVII, os filósofos naturais começam a montar um ataque sustentado contra o programa filosófico escolástico, que unia filosofia e teologia.[37] Também propuseram que a descrição matemática de áreas como a Mecânica e Astronomia poderiam universalizar as características dos movimentos.[38]

Um dos grandes nomes desta época é o italiano Galileu Galilei. Uma das maiores contribuições de Galileu foi reconhecer que o papel de um cientista não era explicar o "porquê" dos fenômenos, mas somente descrevê-los.[39] Em um de suas obras, Discursos e Demonstrações Matemáticas acerca de Duas Novas Ciências Galileu levanta a questão de por que um objeto cai sem sustentação. Na réplica, Galileu diz que não explicou nada, apenas o descreveu.[39] Galileu simplificou o papel de um cientista, sua função é apenas fazer uma descrição, sem procurar os "porquês" que ele mesmo não pode responder.[39] Galileu foi um dos pioneiros a reconhecer na matemática uma ferramenta para descrever os fenômenos naturais e confirmá-los através de experimentações.[39]

Os estudos de Galileu recaíram no estudo de movimento de projéteis,[40] da queda livre[41] e na Astronomia.[42] Galileu concluiu que os movimentos verticais e horizontais são independentes[40] e que a distância percorrida por um objeto em queda livre é proporcional ao quadrado do intervalo de tempo decorrido.[41] Galileu também aperfeiçoou o telescópio e descobriu os satélites galileanos, os quatro maiores satélites de Júpiter, e as fases de Vênus, o que levou Galileu a defender o heliocentrismo[34] e a ser condenado pela Igreja pelo seu ato.[43]

Os métodos de Galileu, além de cientistas contemporâneos, como Johannes Kepler e William Gilbert, já eram uma derivação da nova forma de se pensar da época, uma nova forma de filosofia que vinha sido desenvolvida, entre outros, pelo francês René Descartes e pelo inglês Francis Bacon, que veio a ficar conhecido como método científico. Tal forma de se pensar já vinha desde os filósofos naturais islâmicos.[44]

Segundo Francis Bacon, a ciência deve ser qualitativa, experimental e indutiva. Deve rejeitar assunções a priori. Se houver uma quantidade suficiente de observações, tais observações devem ser usadas para se induzir ou generalizar os princípios fundamentais envolvidos nos fenômenos a serem estudados.[45]

Nicolau Copérnico

[editar | editar código-fonte]

Jan Matejko, 1872

Museu da Universidade Jagiellonian, Cracóvia

Um grande avanço na astronomia deve-se ao astrônomo polonês Nicolau Copérnico (1473-1543), que propôs em 1543 o modelo heliocêntrico do sistema solar. Esta teoria afirma que a Terra orbita em torno do Sol com outros organismos na galáxia da Terra (um grande grupo de estrelas e outros corpos). Esta teoria heliocêntrica contrariava as ideias do astrônomo greco-egípcio Ptolomeu (século II), que afirmou que a Terra é o centro do universo. O sistema ptolomaico foi aceito por mais de 1 400 anos. Em 270 a.C. o astrônomo grego Aristarco de Samos (c. 310 a.C. - c. 230 a.C. sugeriu que a Terra gira em torno do Sol, mas o conceito de Copérnico foi o primeiro a ser aceito como uma possibilidade científica válida. O livro de Copérnico, De revolutionibus orbium coelestium ("Sobre as Revoluções das Esferas Celestes"), publicado pouco antes de sua morte, em 1543, é frequentemente considerado como o ponto de astronomia moderna definindo onde começou a revolução científica. Tendo feito a suposição de que o Sol era o centro do universo, Copérnico percebeu que as tabelas de cálculo do movimento planetário (gráficos matemáticos que descrevem os movimentos dos planetas) eram muito mais fáceis e mais precisas. A nova perspectiva de Copérnico - juntamente com as observações precisas de Tycho Brahe - foram usadas pelo astrônomo alemão Johannes Kepler (1571-1630) para formular leis sobre movimentos planetários que ainda são aceitas hoje. Entre as leis de Kepler é a ideia de que as órbitas dos planetas são elípticas e não círculos perfeitos.

Johannes Kepler

[editar | editar código-fonte]

Johannes Kepler publicou suas duas primeiras leis em 1609, tendo-as encontrado através da análise das observações astronômicas de Tycho Brahe.[46] Kepler descobriu sua terceira lei, muitos anos depois, e foi publicada em 1619. Na época, as leis de Kepler foram reivindicações radicais. As crenças prevalecente eram (particularmente nas teorias baseadas em epiciclos) em que as órbitas eram círculos perfeitos. A maioria das órbitas planetárias pode ser aproximada quase como círculos, de modo que não é imediatamente evidente que as órbitas são elípticas. Cálculos detalhados para a órbita do planeta Marte indicaram que Kepler estava correto, e ele deduziu que os outros corpos celestes, incluindo aqueles mais longe do Sol, têm órbitas elípticas também. As leis de Kepler e sua análise das observações em que foram baseados desafiaram o modelo geocêntrico longo aceito de Aristóteles e Ptolomeu e, também, apoiou a teoria heliocêntrica de Nicolau Copérnico (embora as elipses de Kepler também suprimiram com as órbitas e epiciclos circulares de Copérnico, tornando a teoria mais correta), por afirmar que a Terra orbitava o Sol, provando que as velocidades dos planetas variavam, e usando órbitas elípticas em vez de órbitas circulares com epiciclos.[46]

René Descartes

[editar | editar código-fonte]

O filósofo francês René Descartes (1596-1650) era bem relacionado e influente dentro das redes experimentais filosofia dos seus dias. Descartes teve uma agenda mais ambiciosa, no entanto, que foi voltado para a substituição da tradição filosófica da escolástica, principalmente. Ao questionar a realidade interpretada através dos sentidos, Descartes procurou restabelecer esquemas explicativos filosóficos, reduzindo todos os fenômenos percebidos como sendo atribuíveis ao movimento de um mar invisível de "corpúsculos". Notavelmente, ele reservou o pensamento humano e Deus a partir de seu esquema, mantendo a estes serem separados do universo físico. Ao propor esta estrutura filosófica, Descartes supõe que os diferentes tipos de movimento, tais como os de planetas como os dos objetos terrestres, não eram fundamentalmente diferentes, mas eram apenas manifestações diferentes de uma cadeia infinita de movimentos obedecendo a princípios universais corpusculares. Particularmente influente fosse sua explicação para movimentos circulares astronômicos em termos de movimento de vórtices de corpúsculos no espaço. Descartes argumentou, de acordo com as crenças, e não os métodos, dos escolásticos, que o vácuo não poderia existir, e sua explicação da gravidade em termos de corpúsculos empurrarem objetos para baixo.[47][48][49]

Descartes, assim como Galileu, estava convencido da importância da explicação matemática, e ele e seus seguidores foram figuras-chave no desenvolvimento da matemática e da geometria no século XVII. Descrições matemáticas cartesianas do movimento afirmaram que todas as formulações matemáticas tiveram que ser justificáveis em termos de ação física direta, uma posição ocupada por Huygens e o filósofo alemão Gottfried Wilhelm Leibniz, que, seguindo a tradição cartesiana, desenvolveu a sua própria alternativa filosófica escolástica, que ele descreveu em seu trabalho de 1714, Mônada. Descartes foi apelidado de "pai da filosofia moderna", e muito posterior a filosofia ocidental é uma resposta a seus escritos, que são estudados de perto até hoje. Em particular, as suas Meditações sobre Filosofia continuam a ser um texto padrão na maioria dos departamentos de filosofia da universidade. A influência de Descartes em matemática é igualmente evidente, o sistema de coordenadas cartesianas - permitindo equações algébricas de serem expressas em formas geométricas em um sistema de coordenadas bidimensional - foi nomeado após ele. Ele é creditado como o pai da geometria analítica, a ponte entre álgebra e geometria, importante para a descoberta de cálculo e análise infinitesimal.

Mecânica clássica

[editar | editar código-fonte]

Não foi até o desenvolvimento do telescópio de Galileo Galilei e as suas observações, que se tornou claro que os céus não foram feitos a partir de uma substância perfeita e imutável. Adotando hipótese heliocêntrica de Copérnico, Galileu acreditava que a Terra era o mesmo que outros planetas. Galileu pode ter realizado o famoso experimento de deixar cair duas balas de canhão da torre de Pisa. A teoria e a prática mostrou que ambos bateram no chão ao mesmo tempo) Embora a realidade desta experiência é disputada, dela se realizaram experimentos quantitativos de balas rolando em um plano inclinado, com sua teoria correta do movimento acelerado, aparentemente derivada a partir dos resultados das experiências. Galileu também descobriu que um corpo caído na vertical atinge o solo ao mesmo tempo como um corpo projetado horizontalmente, portanto, uma Terra em rotação uniforme ainda terá objetos que caem no chão pela gravidade. Mais significativamente, afirmou que o movimento uniforme é indistinguível do resto, e assim formou os fundamentos da teoria da relatividade.[50]

Isaac Newton foi o primeiro a unificar as três leis do movimento (a lei da inércia, o princípio fundamental da dinâmica, e a lei da ação e reação), provando que essas leis regem tanto objetos terrestres e celestes. Newton e a maioria de seus contemporâneos, com a notável exceção de Christiaan Huygens, esperaram que a mecânica clássica seria capaz de explicar todas as entidades, incluindo (na forma de óptica geométrica) a luz. Para chegar a seus resultados, Newton inventou uma forma de um ramo inteiramente novo da matemática: cálculo infinitesimal (também inventado independentemente por Gottfried Wilhelm Leibniz), que viria a se tornar uma ferramenta essencial em grande parte do desenvolvimento posterior na maioria dos ramos da física. As descobertas de Newton foram estabelecidas em seu Philosophiæ Naturalis Principia Mathematica (Princípios Matemáticos da Filosofia Natural), a publicação de que em 1687 marcou o início do período moderno da mecânica e astronomia.[50]

Newton era capaz de refutar a tradição mecânica cartesiana que todos os movimentos devem ser explicadas com respeito à força exercida por um apêndice imediato. Usando suas três leis do movimento e a lei da gravitação universal, Newton retirou a ideia de que os objetos seguiram caminhos determinados por formas naturais e por sua vez demonstrou que não só observa regularmente os caminhos, mas todos os futuros movimentos de todo o corpo pode ser deduzindo matematicamente com base no conhecimento de seu movimento existente, a sua massa, e as forças que atuam sobre eles. No entanto, observou movimentos celestes que não se conformavam com precisão a seu invento, e o mesmo, que também era profundamente interessado em teologia, argumentou que Deus interveio para garantir a manutenção da estabilidade do sistema solar.

Leonard Euler estendeu as leis do movimento de corpos celestes rígidos com duas leis adicionais. Euler ajudou a desenvolver a equação de feixe de Euler-Bernoulli, que se tornou um marco da engenharia. Além de aplicar com sucesso as suas ferramentas analíticas para problemas na mecânica clássica, Euler também aplicou essas técnicas para problemas celestes. Seu trabalho em astronomia foi reconhecido por uma série de prêmios na academia de Paris ao longo de sua carreira. Suas realizações incluem determinar com grande precisão as órbitas de cometas e outros corpos celestes, compreender a natureza dos cometas, e calcular a paralaxe do sol. Os cálculos também contribuíram para o desenvolvimento de tabelas de longitude precisas.[51] Além disso, Euler fez importantes contribuições na óptica. Ele discordou da teoria corpuscular de Newton da luz no Opticks, que era então a teoria prevalecente. Seus trabalhos sobre óptica em 1740 ajudaram a garantir que a teoria ondulatória da luz proposta por Christian Huygens se tornaria o modo dominante de pensamento, pelo menos até o desenvolvimento da teoria quântica da luz[52] Depois de Newton, houve reformulações progressivas em sua matemática permitindo soluções para um muito maior número de problemas. O primeiro foi construído em 1788 por Joseph Louis Lagrange, matemático italiano-francês. Na mecânica de Lagrange a solução utiliza o caminho de menor acção e segue o cálculo das variações. William Rowan Hamilton reformulou mecânica de Lagrange em 1833. A vantagem da mecânica hamiltoniana era que sua estrutura permitiu um olhar mais profundo para os princípios subjacentes. A maior parte do quadro da mecânica de Hamilton pode ser vista na mecânica quântica no entanto os significados dos termos exactos variam devido a efeitos quânticos.[51]

Desenvolvimentos do século XVIII

[editar | editar código-fonte]Durante o século XVIII, a mecânica fundada por Newton foi desenvolvida por vários cientistas como mais matemáticos que aprenderam o cálculo e o elaboraram em cima de sua formulação inicial. A aplicação da análise matemática para problemas de movimento ficou conhecido como mecânica racional, ou matemática mista (e mais tarde foi chamada de mecânica clássica).

A mecânica de Newton recebeu brilhante exposição na Mecânica Analítica (1788) de Joseph Louis Lagrange e Mecânica Celeste (1799-1825) de Pierre-Simon Laplace. O matemático suíço Daniel Bernoulli (1700-1782) fez estudos matemáticos importantes do comportamento dos gases, antecipando a teoria cinética dos gases desenvolvidos mais de um século mais tarde, e tem sido referido como a primeiro físico matemático dessa área. De Bernoulli e sua dinâmica de fluidos foi introduzida em 1738, o seu trabalho Hydrodynamica.[53]

A mecânica racional tratou principalmente com o desenvolvimento de tratamentos matemáticos elaborados de movimentos observados, utilizando os princípios de Newton como base, e enfatizou a melhoria da tratabilidade de cálculos complexos e desenvolvimento de meios legítimos de aproximação analítica. Um livro contemporâneo representante foi publicado por Johann Baptiste Horvath. Até o final do século, tratamentos analíticos eram suficientemente rigorosos para verificar a estabilidade do sistema solar apenas com base em leis de Newton, sem referência à intervenção divina, até mesmo como tratamentos determinísticos de sistemas tão simples como o problema de três corpos em gravitação, permaneceu intratável.[54]

Em 1705, Edmond Halley previu a periodicidade do cometa Halley, William Herschel descobriu Urano em 1781, e Henry Cavendish mediu a constante gravitacional e determinou a massa da Terra em 1798. Em 1783, John Michell sugeriu que alguns objetos podem ser tão grandes que nem mesmo a luz pode escapar.

Trabalhos britânicos, realizados por matemáticos como Brook Taylor e Colin Maclaurin, caíram para trás com desenvolvimentos concomitantemente com a progressão do século. Enquanto isso, o trabalho floresceu em academias científicas no continente, liderado por esses matemáticos como Bernoulli, Euler, Lagrange, Laplace e Legendre. No final do século, os membros da Academia Francesa de Ciências tinha atingido claro domínio no campo.[55][56][57]

Ao mesmo tempo, a tradição experimental estabelecida por Galileu e seus seguidores persistiram. A Royal Society e da Academia Francesa de Ciências foram os principais centros para a realização e elaboração de relatórios de trabalho experimental. Experimentos em mecânica, óptica, magnetismo, eletricidade estática, química e fisiologia não foram claramente distinguidos um do outro durante o século XVIII, mas diferenças significativas em esquemas explicativos e, assim, design experimentais foram surgindo. Experimentadores químicos, por exemplo, desafiaram as tentativas de impor um esquema de forças de Newton abstratas para filiações químicas, focados no isolamento e classificação de substâncias químicas e reações.[58]

Termodinâmica

[editar | editar código-fonte]

No século XVII, as noções básicas de calor e de temperatura já estavam estabelecidas. Os cientistas daquela época já estavam convencidos de que tais propriedades físicas estavam associadas aos movimentos das estruturas microscópicas da matéria.[59][60] Entretanto, no século seguinte, a noção de que o calor era uma substância fluida tornou-se dominante.[59]

Apenas na década de 1840 James Prescott Joule e outros cientistas começaram a derrubar esta forma de pensamento e, na década seguinte, tornou-se aceito que o calor é de fato uma forma de energia.[59][61] A relação entre calor e energia tornou-se importante para o desenvolvimento de máquinas a vapor.[62] Ainda em 1824, o francês Sadi Carnot já tinha em mente algumas ideias rudimentares de termodinâmica para discutir a eficiência de máquinas térmicas idealizadas.[63]

No século XIX, a relação entre calor e energia mecânica foi estabelecida quantitativamente por Julius Robert von Mayer e James Prescott Joule, que mediram o equivalente mecânico do calor na década de 1840. Em 1849, Joule publicou os resultados de sua série de experimentos (incluindo a experiência de pás) que mostram que o calor é uma forma de energia, fato que foi aceito em 1850. A relação entre a energia e calor era importante para o desenvolvimento dos motores a vapor e, em 1824, o trabalho experimental e teórico de Carnot foi publicado. Carnot capturou algumas das ideias da termodinâmica em sua discussão sobre a eficiência de um motor idealizado. O trabalho de Sadi Carnot serviram de base para a formulação da primeira lei da termodinâmica - uma reafirmação da lei da conservação da energia - o que foi afirmado por volta de 1850 por William Thomson,mais tarde reafirmado por Lord Kelvin e Rudolf Clausius.

Kelvin, que ampliou o conceito de zero absoluto de gases para todas as substâncias, em 1848, baseou-se na teoria de engenharia de Lazare Carnot, Sadi Carnot, e Émile Clapeyron - bem como a experimentação de James Prescott Joule sobre a intercambialidade de mecânica, química, as formas térmicas e elétricas de trabalho - para formular a primeira lei.

Kelvin e Clausius também formularam a segunda lei da termodinâmica, a qual foi originalmente formulada em termos do fato de que o calor não flui espontaneamente a partir de um corpo mais frio para um mais quente. Outras formulações seguindo rapidamente (por exemplo, a segunda lei foi exposta por Thomson em influente obra de Peter Guthrie Tait em (Filosofia Natural). A segunda lei é a ideia de que os gases consistem de moléculas em movimento havia sido discutido em detalhes por Daniel Bernoulli em 1738, mas caiu em desuso, e foi revivida por Clausius em 1857.

Em 1850, Hippolyte Fizeau e Léon Foucault mediram a velocidade da luz na água e descobriram que ela é mais lenta do que no ar, em apoio ao modelo de onda de luz. Em 1852, Joule e Thomson demonstraram que um gás se expandindo rapidamente esfria, mais tarde chamado de efeito Joule-Thomson ou efeito Joule-Kelvin. Hermann von Helmholtz propôs a ideia da morte térmica do universo em 1854, o mesmo ano em que Clausius estabeleceu a importância de dQ / T (Teorema de Clausius).

Eletromagnetismo

[editar | editar código-fonte]

A humanidade conhece as forças magnética e elétrica desde a antiguidade, mas apenas os gregos antigos a partir do quarto século a.C. começaram a refletir racionalmente sobre suas propriedades.[8][64]

Entretanto, as investigações sistemáticas não começaram até a Idade Média; os fenômenos magnéticos começaram a ser explorados primeiramente.[65] No século XII, a bússola já era conhecida na Inglaterra.[66] O francês Pedro de Maricourt concluiu que uma agulha magnetizada alinha-se longitudinalmente a um ímã esférico, alinhando-se a dois pontos que Maricourt chamou de polos magnéticos.[67]

Entretanto, um dos primeiros cientistas a realizar estudos sistemáticos sobre eletricidade e magnetismo foi o inglês William Gilbert, no século XVI.[68] Gilbert confirmou os trabalhos de Maricourt e especulou corretamente que a Terra é um gigantesco ímã.[68] No seu livro, De magnete, Gilbert descreveu também que a força elétrica pode ser observada em vários materiais friccionados. Ele atribuiu este fenômeno à remoção de um "fluido elétrico" devido à fricção e chamou esta propriedade como fenômeno "elétrico", termo derivado do grego elektrum, que significa âmbar.[68]

Otto von Guericke construiu o primeiro gerador eletrostático utilizando a fricção de uma esfera de enxofre.[69] Pieter van Musschenbroek é o primeiro a publicar trabalhos sobre a "garrafa de Leiden", um dos primeiros acumuladores de carga, antecessor do capacitor.[69] Benjamin Franklin foi um dos primeiros a propor que um corpo contém quantidades iguais de cargas negativas e positivas, que sob circunstâncias normais, são neutralizadas uma pela outra.[70] O ato de eletrificar seria a separação das duas "formas" de eletricidade, a negativa e a positiva. Franklin demonstrou seus argumentos e propôs que os raios de tempestades não passariam de gigantescas centelhas que neutralizariam as cargas elétricas presentes no solo e nas nuvens. No famoso experimento da pipa, Franklin conseguiu com sucesso armazenar cargas elétricas de uma nuvem de tempestade em uma garrafa de Leiden.[70]

As primeiras tentativas de quantificação da eletricidade e do magnetismo se iniciaram no século XVIII.[71] Charles Augustin de Coulomb inventou a balança de torção para medir com precisão as forças envolvidas em corpos carregados eletricamente.[72] Coulomb concluiu que a força elétrica é inversamente proporcional ao quadrado da distância, o que ficou conhecido como a lei de Coulomb.[72] No final do século XVIII e no início do século XIX, vários grandes físico-matemáticos conceberam vários formalismos matemáticos para os fenômenos elétricos e magnéticos, como Siméon Denis Poisson, Pierre-Simon Laplace e Carl Friedrich Gauss.[65] Alessandro Volta descobriu que dois metais diferentes em contato produziam um potencial elétrico.[73] Usando isso, Volta construiu a primeira "pilha voltaica". Tal pilha poderia produzir uma corrente elétrica com ordens de magnitude maior do que já se tinha feito até então com geradores eletrostáticos.[73]

Sabia-se, até então, que a eletricidade e o magnetismo estavam relacionados apenas nos formalismos matemáticos semelhantes, exceto que o magnetismo não tinha monopolos. No entanto, sabia-se que um raio poderia defletir a agulha de uma bússola.[74] Hans Christian Ørsted, que estava filosoficamente convencido da união das forças da natureza, ao saber da pilha voltaica, realizou experimentos com grandes correntes e percebeu que a força magnética está presente em uma corrente elétrica.[74] Ao saber dos trabalhos de Ørsted, André-Marie Ampère desenvolveu uma completa teoria quantitativa fundamentada matematicamente.[75] Ampère foi além: por meio de experimentos, concluiu que a força magnética de um magneto permanente é exatamente equivalente à força magnética de um condutor de eletricidade, considerando-se a intensidade da corrente elétrica ou o número de espiras de um condutor enrolado (que Ampère chamou de solenoide). Ampère também concluiu que um magneto permanente deve conter correntes elétricas fechadas em seu interior e que a magnetização é o alinhamento de moléculas dotadas de magnetismo.[75]

Michael Faraday introduziu o conceito de "campo", o que simplificou a matemática que descrevia os fenômenos elétricos e magnéticos.[76] Segundo Faraday, a presença de cargas elétricas e magnéticas causavam uma "distorção" no espaço. A esta "distorção" Faraday chamou de campo. A ação do campo ocorria sob a forma de "linhas de força".[76] Impressionado com os trabalhos de Ørsted, Faraday propôs o inverso, a variação da força magnética causaria corrente elétrica.[77] Após dez anos de tentativas, em 1831 Faraday pôde demonstrar experimentalmente suas ideias. Faraday foi além: construiu o primeiro motor elétrico, o primeiro transformador e o primeiro dínamo.[78] Faraday também tentou explicar os fenômenos elétricos e magnéticos microscopicamente, afirmando que a polarização dos objetos era devida a rotação de átomos dipolares (a ideia de átomo ainda estava sendo levantada à época, e não se previa a existência do elétron).[79] Faraday também argumentava que a luz era uma manifestação do eletromagnetismo e cogitou a hipótese de unificar as forças elétrica e magnética à gravitação.[80]

James Clerk Maxwell foi o grande unificador dos trabalhos dos cientistas do século XIX, unindo, sob a mesma teoria fundamentada matematicamente, os trabalhos de Gauss, Ampère e Faraday, com várias correções próprias.[81] Iniciando seus trabalhos com foco nas linhas de força de Faraday, Maxwell fundamentou toda a base matemática da teoria eletromagnética observando similaridades com outras áreas da física clássica, como termodinâmica e hidrodinâmica. Seu trabalho é resumido em apenas quatro equações, conhecidas atualmente como as equações de Maxwell.[81] Demonstrou matematicamente a velocidade da luz usando apenas princípios eletromagnéticos, o que finalmente levou a Óptica a ser fundida com a teoria eletromagnética.[82] Em 1888, Heinrich Rudolf Hertz confirmou experimentalmente a existência das ondas eletromagnéticas previstas por Maxwell.[82] O trabalho de Maxwell serviu como base para a futura revolução tecnológica ocorrida no século XX.[81]

Mecânica estatística

[editar | editar código-fonte]

Em 1738, o físico e matemático suíço Daniel Bernoulli publicou Hydrodynamica que lançou as bases para a teoria cinética dos gases. Neste trabalho, Bernoulli postulou o argumento, ainda usado até hoje, que os gases consistem em um grande número de moléculas que se movem em todas as direções, o seu impacto sobre a superfície faz com que a pressão do gás que sentimos, e que o que experimentamos como o calor é simplesmente a energia cinética do seu movimento.

Em 1859, depois de ler um artigo sobre a difusão de moléculas por Rudolf Clausius,o físico escocês James Clerk Maxwell formulou a distribuição de Maxwell das velocidades moleculares, o que deu a proporção de moléculas com uma certa velocidade em um intervalo específico. Esta foi uma lei de estatística primeira vez usada na física.[83] Cinco anos depois, em 1864, Ludwig Boltzmann, um jovem estudante de Viena, através do papel de Maxwell na física estatística, estava tão inspirado, por ela que ele passou boa parte de sua vida desenvolvendo o assunto adiante.

Assim, os fundamentos da termodinâmica estatística foram estabelecidas no final de 1800 por aqueles como: Maxwell, Boltzmann, Max Planck, Clausius, e Josiah Willard Gibbs, que começaram a aplicar a teoria atômica estatística e quântica aos órgãos de gases ideais. Predominantemente, no entanto, foi Maxwell e Boltzmann, trabalhando de forma independente, que chegaram a conclusões semelhantes quanto à natureza estatística dos corpos gasosos. No entanto, é preciso considerar Boltzmann como sendo o "pai" da termodinâmica estatística com o seu trabalho, em 1875, sobre derivação da relação entre a entropia S e multiplicidade Ω, o número de arranjos microscópicos (microestados) que produzem o mesmo estado macroscópico (macroestado) para um determinado sistema.[84]

Teoria atômica

[editar | editar código-fonte]

Perto do final do século XVIII, duas leis sobre reações químicas surgiram sem se referir à noção de uma teoria atômica. A primeira foi a lei da conservação de massa, formulada por Antoine Lavoisier em 1789, que afirma que a massa total em uma reação química se mantém constante (isto é, os reagentes têm a mesma massa que os produtos). A segunda foi a lei das proporções definidas, Lei de Proust. Primeiro provada pelo químico francês Joseph Louis Proust em 1799, esta lei estabelece que se um composto é decomposto nos seus elementos constitutivos, em seguida, as massas dos constituintes terão sempre as mesmas proporções, independentemente da quantidade ou da fonte da substância original.[85]

John Dalton estudou e expandiu este trabalho anterior e desenvolveu a lei de Dalton: se dois elementos se juntam para formar mais do que um composto, então a razão entre as massas do segundo elemento que se combina com uma massa fixa do primeiro elemento vai em razões de inteiros pequenos. Por exemplo, estudou Proust e sua teoria dos óxidos de estanho e verificou que as suas massas eram de estanho 88,1% e 11,9% de oxigénio ou 78,7% de estanho e 21,3% de oxigénio (estes eram de estanho (II) e óxido de dióxido de estanho, respectivamente). Dalton observou a partir desses percentuais que 100 g de estanho vai combinar tanto com 13,5 g ou 27 g de oxigênio, 13,5 e 27 formam uma proporção de 1:2.

Dalton encontrou uma teoria atômica da matéria poderia elegantemente explicar esse padrão comum na química - no caso dos óxidos de estanho de Proust, um átomo de estanho vai combinar com um ou dois átomos de oxigênio.[86]

Em Um novo sistema de Química Filosofia (1808) de John Dalton

Dalton também acreditava teoria atômica poderia explicar por que a água era absorvida por diferentes gases em diferentes proporções: Por exemplo, ele descobriu que a água absorvida por dióxido de carbono era muito melhor absorvida do que por nitrogênio. A Hipótese de Dalton foi devido às diferenças de massa e da complexidade das respectivas partículas de gases. Com efeito, as moléculas de dióxido de carbono (CO2) são mais pesadas e maiores do que as moléculas de nitrogênio (N2). Dalton propôs que cada elemento químico é composto por átomos de um único tipo único, e que eles não podem ser alterados ou destruídos por meios químicos, eles podem se combinar para formar uma estrutura mais complexa (compostos químicos). Isto marcou a primeira teoria verdadeiramente científica do átomo, Dalton chegou a suas conclusões através de experimentação e análise dos resultados de uma forma empírica.

Em 1803 Dalton apresentou oralmente a sua primeira lista de pesos atômicos relativos para uma série de substâncias. Este artigo foi publicado em 1805, mas ele não discutiu exatamente como ele obteve estes resultados.

O método foi revelado pela primeira vez em 1807 por Thomas Thomson, na terceira edição do livro de Thomson, um sistema de Química. Finalmente, Dalton publicou um relato completo em seu próprio livro, A New System of Chemical Philosophy, entre 1808 e 1810. Dalton estimou os pesos atómicos de acordo com as razões de massa em que se combinavam com o átomo de hidrogénio tomado como unidade. No entanto, Dalton não concebeu que com alguns elementos átomos existem em moléculas puras - existe oxigênio puro como O2. Ele também acreditou, equivocadamente, que o composto mais simples entre dois elementos é sempre um átomo de cada um (então ele pensou água como HO, não H2O).[87] A falha na teoria de Dalton foi corrigida, em princípio, em 1811 por Amedeo Avogadro. Avogadro propôs que os volumes iguais de quaisquer dois gases, a mesma temperatura e pressão, contêm quantidades iguais de moléculas (por outras palavras, a massa de partículas de um gás não afecta o volume de gás que ocupa, o que, por sua vez, é muito maior do que o volume da própria molécula). A lei de Avogadro permitiu-lhe deduzir a natureza diatómica de numerosos gases, estudando os volumes em que eles reagiam.[88]

Física moderna

[editar | editar código-fonte]

No final do século XIX, a física evoluiu até o ponto em que a mecânica clássica poderia lidar com problemas altamente complexos, que envolvem situações macroscópicas; termodinâmica e a teoria cinética estavam bem estabelecidas, óptica geométrica e física podem ser entendidas em termos de ondas eletromagnéticas, e as leis de conservação de energia e momento (e massa) eram amplamente aceitas. Tão profundos eram estes e outros desenvolvimentos que era geralmente aceito que todas as importantes leis da física tinham sido descobertas e que, doravante, a pesquisa estaria preocupada com esclarecimento de problemas menores e, particularmente, com a melhoria do método e de medição. No entanto, por volta de 1900 sérias dúvidas surgiram sobre a integridade das teorias clássicas - o triunfo das teorias de Maxwell, por exemplo, foi prejudicada por deficiências que já tinham começado a aparecer - e sua incapacidade de explicar certos fenômenos físicos, tais como a distribuição de energia em radiação do corpo negro e o efeito fotoelétrico, enquanto algumas das formulações teóricas levou a paradoxos quando levada ao limite. Físicos proeminentes como Hendrik Lorentz, Emil Cohn, Ernst Wiechert e Wilhelm Wien acreditavam que alguma modificação das equações de Maxwell poderia fornecer a base para todas as leis físicas. Estas deficiências da física clássica nunca foi resolvido e novas ideias eram necessárias. No início do século XX, uma grande revolução abalou o mundo da física, o que levou a uma nova era, geralmente referida como a física moderna.

Experimentos com radiação

[editar | editar código-fonte]No século XIX, os pesquisadores começaram a detectar formas inesperadas de radiação: Wilhelm Röntgen causou sensação com sua descoberta dos raios X, em 1895, em 1896, Henri Becquerel descobriu que certos tipos de matéria emitem radiação do nada. Em 1897, J.J. Thomson descobriu o elétron, e novos elementos radioativos encontrados por Marie e Pierre Curie levantaram questões sobre o átomo ser supostamente indestrutível e da natureza da matéria. Marie e Pierre Curie cunharam o termo "radioatividade" para descrever esta propriedade da matéria, e isolaram elementos radioativos de rádio e polônio. Ernest Rutherford e Frederick Soddy identificaram duas formas de radiação de Becquerel com elétrons e do elemento hélio. Rutherford identificou e nomeou dois tipos de radioatividade em 1911 e interpretou como a evidência experimental que mostra que o átomo consiste de uma camada densa, carregada positivamente de um núcleo rodeado por electrões de carga negativa. A teoria clássica, no entanto, previa que esta estrutura deveria ser instável. A teoria clássica também não conseguiu explicar com sucesso dois outros resultados experimentais que apareceram no final do século XIX. Uma delas foi a demonstração por Albert Michelson e Edward Morley - conhecida como a experiência de Michelson-Morley - que mostrou que não parecia ser um quadro preferido de referência, em repouso em relação ao hipotético éter luminoso, para descrever fenômenos eletromagnéticos. Estudos da radiação e decaimento radioativo continuaram a ser um foco de destaque para a pesquisa física e química durante os anos 1930, quando a descoberta da fissão nuclear abriu o caminho para a exploração prática do que veio a ser chamado de energia "atômica".

Teoria da relatividade

[editar | editar código-fonte]Em 1905, um jovem de 26 anos de idade, físico alemão (então um funcionário de patentes de Berna) chamado Albert Einstein (1879-1955), mostrou como as medições de tempo e espaço são afetados pelo movimento entre um observador e quem está sendo observado. Para dizer que a teoria radical da relatividade de Einstein revolucionou a ciência não é exagero. Embora Einstein fez muitas outras contribuições importantes para a ciência, a teoria da relatividade, sozinha, representa uma das maiores conquistas intelectuais de todos os tempos. Embora o conceito de relatividade não foi introduzida por Einstein, a sua grande contribuição foi o reconhecimento de que a velocidade da luz no vácuo é constante e um limite físico para o movimento absoluto. Isto não tem um grande impacto na vida do dia-a-dia de uma pessoa, uma vez que viajar a uma velocidade muito mais lenta do que a velocidade da luz é cotidiano. Para objetos que viajam perto da velocidade da luz, no entanto, a teoria da relatividade afirma que os objetos se moverão mais lento e diminuirão em comprimento do ponto de vista de um observador na Terra. Einstein também derivou a famosa equação E = mc2, que revela a equivalência entre massa e energia.

Relatividade restrita

[editar | editar código-fonte]

Em 1881, Albert Abraham Michelson e Edward Morley tentaram medir o movimento relativo da Terra e do Éter (Aether-vento), como era esperado na teoria de Augustin-Jean Fresnel, usando um interferômetro. Ele não poderia determinar qualquer movimento relativo, por isso ele interpretou o resultado como uma confirmação da tese de George Gabriel Stokes de que o éter foi totalmente absorvido pela matéria (mais tarde este ponto de vista também foi partilhado por Hertz).[89] No entanto, Lorentz apresentou os cálculos de Michelson como errados e que ele superestimou a precisão da medição. Isto, juntamente com a grande margem de erro, feito o resultado da experiência de Michelson inconclusivos. Além disso, Lorentz mostrou que as teorias Gabriel Stokes do éter levavam a conseqüências contraditórias e, portanto, ele apoiou uma teoria do éter semelhante ao de Fresnel.[90] Para verificar a teoria de Fresnel de novo, Michelson e Edward Morley (1886) realizaram uma repetição do experimento de Hippolyte Fizeau. Para esclarecer a situação, Michelson e Morley (1887) repetiram a experiência de, e eles aumentaram substancialmente a precisão da medida. No entanto, a experiência de Michelson-Morley novamente rendeu um resultado negativo, ou seja, nenhum movimento do éter através aparelho foi detectado. Assim, os físicos foram confrontados com duas experiências aparentemente contraditórias:. 1886- A experiência como uma confirmação evidente de éter estacionário de Fresnel, e em 1887- experimento como uma confirmação evidente de éter completamente absolvido de Stokes.

Hendrik Lorentz (1892) estabeleceu as bases da teoria do éter, assumindo a existência de elétrons que seriam separados do éter, e substituindo as "equações de Maxwell-Hertz" pelas equações "Maxwell-Lorentz". Em seu modelo, o éter é completamente imóvel e, ao contrário da teoria de Augustin-Jean Fresnel, também não é parcialmente arrastado pela matéria. Uma consequência importante desta ideia foi a de que a velocidade da luz é totalmente independente da velocidade da fonte. Lorentz não deu declarações sobre a natureza mecânica do éter e os processos eletromagnéticos, mas, vice-versa, tentou explicar os processos mecânicos por outros eletromagnéticas e, portanto, criou uma Éter eletromagnética abstrato. No âmbito de sua teoria, Lorentz calculou a contração dos campos eletrostáticos.[91] Em 1895 Lorentz também apresentou o que chamou de "teorema dos Estados correspondentes" para termos de primeira ordem, este teorema afirma que um observador em movimento (relativo ao éter), em seu campo "fictício" faz com que sejam as mesmas observações como um observador em repouso em seu campo "real". Uma parte importante, que abriu o caminho para a transformação de Lorentz. Com a ajuda deste conceito, Lorentz poderia explicar a aberração da luz, efeito Doppler e a experiência de Fizeau. No entanto, o conceito de hora local de Lorentz era apenas uma ferramenta matemática auxiliar para simplificar a transformação de um sistema para outro - foi Henri Poincaré em 1900, que reconheceu que o "tempo local" é realmente indicado por relógios em movimento.

Na segunda metade do século XIX houve muitas tentativas para desenvolver uma rede mundial relógios sincronizados por sinais elétricos. Na ocasião, a velocidade de propagação finita da luz teve que ser considerada. Assim Henri Poincaré (1898) no seu artigo "A Medida do Tempo" tirou algumas conclusões importantes deste processo e explicou a astrônomos, que para determinar a velocidade da luz, simplesmente deveriam assumir que a luz tem uma velocidade constante, e que esta velocidade é a mesma em todos as direcções.[92] Sem esse postulado seria impossível inferir a velocidade da luz a partir de observações astronômicas, como Ole Rømer se baseou em observações das luas de Júpiter. Poincaré também notou que a velocidade de propagação da luz pode ser (e, na prática, muitas vezes é) utilizada para definir a simultaneidade entre eventos separados espacialmente.[92]

Em alguns outros trabalhos, Poincaré (1895 a 1900) argumentou que as experiências, como a de Michelson e Morley havia a impossibilidade de detectar o movimento absoluto da matéria, isto é, o movimento relativo da matéria em relação ao éter. Ele chamou isso de "princípio de movimento relativo.".[93] No mesmo ano, ele interpretou a hora local de Lorentz como o resultado de um procedimento de sincronização com base em sinais de luz. Ele assumiu que dois observadores A e B, que estão se movendo no éter, a sincronizar seus relógios através de sinais ópticos. Uma vez que eles acreditam estar em repouso, eles devem considerar apenas o tempo de transmissão dos sinais e, em seguida, cruzar as suas observações para analisar se os relógios estão sincronizados. No entanto, do ponto de vista de um observador em repouso no éter, os relógios não são síncronos e indicam a hora local. Mas porque os observadores em movimento não sabem nada sobre o seu movimento, eles não reconhecem isso. Assim, ao contrário do Lorentz, Poincaré definiu que o horário local pode ser medido e indicado por relógios.[94]

Em 26 de setembro de 1905, Albert Einstein publicou seu artigo Annus mirabilis sobre o que hoje é chamado de Teoria Especial da Relatividade. O trabalho de Einstein inclui uma nova definição fundamental do espaço e do tempo (todo o tempo e coordenadas de espaço em todos os quadros de referência são iguais, por isso não há "verdadeiro" ou "aparente" do tempo) e a abolição do éter. Ele identificou dois princípios fundamentais, o princípio da relatividade e o princípio da constância da Luz, que serviu de base axiomática de sua teoria.

Relatividade geral

[editar | editar código-fonte]Logo após a publicação da teoria da relatividade especial, em 1905, Einstein começou a pensar em como incorporar a gravidade em seu novo quadro relativista. Em 1907, começando com uma experiência de pensamento simples, envolvendo um observador em queda livre, ele embarcou no que seria uma pesquisa de oito anos para uma teoria relativística da gravidade. Depois de vários desvios e falsos começos, seu trabalho culminou com a apresentação da Academia Prussiana de Ciências, em novembro de 1915, do que agora são conhecidos como as equações de campo de Einstein. Essas equações podem especificar como a geometria do espaço e do tempo é influenciada por qualquer matéria e radiação estão presentes, e formam o núcleo da teoria geral da relatividade de Einstein.[95]

As equações de campo de Einstein são não-lineares e muito difíceis de se resolver. Einstein usou métodos de aproximação na elaboração de previsões iniciais da teoria. Mas, como em 1916, o astrofísico Karl Schwarzschild encontrou a primeira solução exacta não trivial com as equações de campo de Einstein, a chamada métrica de Schwarzschild. Esta solução lançou as bases para a descrição das fases finais do colapso gravitacional, e os objetos conhecidos hoje como buracos negros. No mesmo ano, foram dados os primeiros passos no sentido de generalizar a solução de Schwarzschild para objetos carregados eletricamente, o que acabou resultando na solução de Reissner-Nordström, agora associada a buracos negros carregados eletricamente.[96]

Em 1917, Einstein aplicou sua teoria para o universo como um todo, iniciando o campo da cosmologia relativista. Em sintonia com o pensamento contemporâneo, ele assumiu um universo estático, adicionando um novo parâmetro para o seu campo original de equações da constante cosmológica que reproduziram essa "observação".[97] Em 1929, no entanto, o trabalho de Edwin Hubble e outros haviam mostrado que nosso universo está se expandindo. Georges Lemaître usou essas soluções para formular a versão mais recente dos modelos de Big Bang, no qual nosso universo evoluiu a partir de um estado anterior, extremamente quente e denso. Einstein mais tarde declarou a constante cosmológica o maior erro de sua vida.[98]

A derivação de equações de uma ação tem várias vantagens. Primeiro de tudo, permite a unificação fácil da relatividade geral com outros campos teorias clássicas (como a teoria de Maxwell), que também são formuladas em termos de uma ação. Na relatividade geral, a ação é geralmente considerada como uma funcional da métrica (e campos de matéria), e a conexão é dada pela conexão de Levi-Civita. A formulação de Palatini da relatividade geral assume a métrica e ligação a serem independentes, e varia com respeito a ambos, independentemente, o que faz com que seja possível incluir campos de matéria fermiônicas com spin não integral. As equações de Einstein na presença de matéria são dadas por adição de matéria para a acção da ação de Hilbert. A ação foi proposta pela primeira vez por David Hilbert em 1915 que deu início à mecânica relativística.

Teoria quântica

[editar | editar código-fonte]

A investigação científica sobre a natureza ondulatória da luz volta aos séculos 17 e 18, quando cientistas como Robert Hooke, Christian Huygens e Leonhard Euler propuseram uma teoria ondulatória da luz com base em observações experimentais.[99] Em 1803, Thomas Young, um polímata inglês, realizou o famoso experimento da dupla fenda que ele descreveu mais tarde em um artigo intitulado "Sobre a natureza da luz e das cores." Este experimento teve um papel importante na aceitação geral da teoria ondulatória da luz. Em 1838, com a descoberta dos raios catódicos por Michael Faraday, acompanhado pela declaração de 1859 do problema da radiação do corpo negro por Gustav Kirchhoff, veio a sugestão, em 1877, por Ludwig Boltzmann que os estados de energia de um sistema físico podem ser discretos, e a hipótese 1900 quantum de Max Planck ganhou base. A hipótese de Planck que a energia é irradiada e absorvida em discretas "quanta" (ou "elementos de energia"), combinado com precisão os padrões observados da radiação de corpo negro.

Em 1896, Wilhelm Wien determinou empiricamente uma lei de distribuição de radiação do corpo negro, conhecida como lei de Wien em sua honra. Ludwig Boltzmann chegou de forma independente a esse resultado por considerações das equações de Maxwell. No entanto, essa lei válida apenas em altas freqüências, e subestimou a radiação em baixas frequências. Mais tarde, Max Planck corrigiu este modelo usando interpretação estatística de Boltzmann da termodinâmica e propôs o que agora é chamado de lei de Planck, o que levou ao desenvolvimento da Mecânica Quântica. De acordo com Planck, a energia de cada elemento E é proporcional à sua frequência ν: em que h é a constante de Planck. Planck, com cautela, insistiu que isso era simplesmente um aspecto dos processos de absorção e emissão de radiação e não tinha nada a ver com a realidade física da própria radiação.[100] Na verdade, ele considerou a sua hipótese quântica de um truque matemático para obter a resposta certa, em vez de uma descoberta considerável. No entanto, em 1905, Albert Einstein interpretou essa hipótese quântica de Planck realista e é usado para explicar o efeito fotoelétrico, em que um raio de luz em certos materiais pode ejetar elétrons do material.

O modelo quântico do átomo

[editar | editar código-fonte]Esta seção foi marcada para revisão devido a incoerências ou dados de confiabilidade duvidosa. (Fevereiro de 2023) |

No início do século XX, os experimentos de Ernest Rutherford estabeleceu que os átomos consistiam de uma nuvem difusa de elétrons carregados negativamente em torno de um pequeno, denso, núcleo de carga positiva.[101] Em posse desses dados experimentais, Rutherford naturalmente considerou um modelo-planetário do átomo, o modelo de Rutherford de 1911. - elétrons que orbitam o núcleo solar - no entanto, tinha uma dificuldade técnica. As leis da mecânica clássica (ou seja, a fórmula de Larmor), prevêem que o elétron vai liberar radiação eletromagnética, enquanto em órbita de um núcleo. Porque o elétron perderia energia, seria movido gradualmente para o interior da espiral, entrando em colapso no núcleo. Este modelo do átomo é desastroso, pois prevê que todos os átomos são instáveis. Para superar esta dificuldade, Niels Bohr propôs, em 1913, o que hoje é chamado de modelo de Bohr do átomo. Ele sugeriu que os elétrons só poderia ter certos movimentos clássicos:

1.Elétrons nos átomos orbitam o núcleo.

2.Os elétrons só podem orbitar estavelmente, sem irradiação, em certas órbitas (chamadas de as órbitas "fixas"): em um determinado conjunto discreto de distâncias a partir do núcleo.

3.Estas órbitas estão associados com energias definidas e também são chamados de níveis de energia. Nestes órbitas, a aceleração do elétron não irá resultar na perda de energia, conforme exigido por modelos clássicos.

4.Os elétrons só pode ganhar e perder energia, saltando de uma órbita permitida para outra, absorvendo ou emitindo radiação eletromagnética com uma freqüência ν determinado pela diferença de energia dos níveis de acordo com a relação de Planck:

onde h é a constante de Planck.

Além disso foram propostos vários aprimoramentos no modelo de Bohr, mais notavelmente o modelo de Arnold Sommerfeld ou modelo de Bohr-Sommerfeld, que sugeriu que os elétrons viajam em órbitas elípticas ao redor de um núcleo, em vez de órbitas circulares do modelo de Bohr. Este modelo complementou a condição de momento angular quantizado do modelo de Bohr com uma condição radial quantização adicional, a condição de quantização Sommerfeld-Wilson.[102]

Princípio da incerteza

[editar | editar código-fonte]

Em 1925, na sequência de um trabalho pioneiro com Hendrik Kramers, Werner Heisenberg desenvolveu a mecânica matricial, que substituiu a velha teoria quântica iniciada por Max Planck para mecânica quântica moderna. A hipótese central foi a de que o conceito clássico de movimento não se encaixa no nível quântico, e que os elétrons em um átomo não viajam em órbitas bem definidas. Pelo contrário, o movimento é espalhado de uma forma estranha: Heisenberg argumentou que o movimento dos elétrons eram em total forma incertos e que ambas a posição e o momento das partículas sub-atômicas não poderiam ser conhecidas simultaneamente. O Papel de Heisenberg não admitiu as quantidades não observáveis, como a posição exata do elétron em uma órbita a qualquer momento. Uma vez que os componentes de Fourier não foram definidos nas freqüências clássicas, eles não poderiam ser usados para construir uma trajetória exata, de modo que o formalismo não poderia responder a certas perguntas demasiado precisas sobre onde o elétron estava ou o quão rápido ele estava indo. Heisenberg mostrou que a relação de comutação implica uma incerteza, ou, na linguagem de Bohr - a complementaridade.

Quaisquer das duas variáveis que não fazem trajeto não podem ser medidos em simultâneo, mais precisamente é conhecido, menos precisamente o outro pode ser conhecido. Heisenberg escreveu:

| “ | Ela pode ser expressa na sua forma mais simples, como se segue: Nunca se pode saber com precisão perfeita ambos destes dois factores importantes que determinam o movimento de uma das menores partículas à sua posição e a sua velocidade. É impossível determinar com precisão a posição e a direção e velocidade de uma partícula no mesmo instante.[103] | ” |

Werner Heisenberg formulou o Princípio da Incerteza no Instituto Niels Bohr, em Copenhague, durante o trabalho sobre os fundamentos matemáticos da mecânica quântica.[104]

Mecânica ondulatória

[editar | editar código-fonte]

Após a quantização da luz (ver radiação do corpo negro) de Max Planck, Albert Einstein interpretou o quanta de Planck sendo fótons, partículas de luz, e propôs que a energia de um fóton é proporcional à sua frequência, um dos primeiros sinais de dualidade onda-partícula. Como a energia e impulso estão relacionadas, da mesma forma como a frequência e número de onda na relatividade especial, seguia-se que o impulso p de um fóton é proporcional ao seu número de onda k.

Em 1924, Louis de Broglie formulou a hipótese de Broglie, alegando que toda a matéria, não apenas a luz, tem uma natureza ondulatória,[105][106] ele relatou comprimento de onda (denotado como λ) e impulso (denotado como p): De acordo com Broglie o electron é descrito por uma onda e um número inteiro de comprimentos de onda deve caber ao longo da circunferência da órbita do mesmo. Esta abordagem, essencialmente limita a onda de electrões numa dimensão, ao longo de uma órbita circular.

Em 1921, antes de Broglie, Arthur C. Lunn na Universidade de Chicago usou o mesmo argumento com base na conclusão do momentum relativista da energia. Ao contrário de Broglie, Lunn passou a formular junto com Schrodinger a equação diferencial agora conhecida como a equação de Schrödinger. Na mecânica quântica, a equação de Schrödinger é uma equação diferencial parcial que descreve como o estado quântico de algumas mudanças no sistema físico ocorre com o passar do tempo. Ela foi formulada no final de 1925, e publicada em 1926, pelo físico austríaco Erwin Schrödinger.

Na mecânica clássica, a equação de movimento é a segunda lei de Newton, e formulações equivalentes são as equações de Euler-Lagrange e equações de Hamilton. Todas estas formulações são usadas para resolver para o movimento de um sistema mecânico e matematicamente prever para onde sistema irá a qualquer momento e para além das definições de configuração dos sistemas iniciais. Na mecânica quântica, o análogo da lei de Newton é a equação de Schrödinger para um sistema quântico (geralmente átomos, moléculas e partículas subatômicas quer livre, limitada, ou localizada).

Teoria quântica de campos

[editar | editar código-fonte]

Na física de partículas, a história da teoria quântica de campos inicia-se com a sua criação por Paul Dirac, quando tentou quantificar o campo eletromagnético à mecânica quântica no final de 1920. Grandes avanços na teoria foram feitas na década de 1950, e levou à introdução da eletrodinâmica quântica (QED). QED foi tão bem sucedida e "natural" que foram feitos esforços para utilizar os mesmos conceitos básicos para as outras forças da natureza. Estes esforços foram bem sucedidos na aplicação de teoria de gauges para a força nuclear forte e a força nuclear fraca, a produção do Modelo padrão de partículas moderna.

A primeira teoria razoavelmente completa da eletrodinâmica quântica, que incluiu tanto o campo eletromagnético e matéria carregada eletricamente (especificamente, elétrons) como objetos quânticos, foi criada por Paul Dirac em 1927.[107] Esta teoria quântica de campo pode ser utilizada para modelar processos importantes, tais como a emissão de um fóton por uma queda de electrões para um estado quantum de energia mais baixo. Compreende-se agora que a capacidade de descrever tais processos é uma das características mais importantes da teoria quântica de campos. Era evidente desde o início que um tratamento adequado quântico do campo eletromagnético tinha de alguma forma incorporar a teoria da relatividade de Einstein, que havia crescido fora do estudo do eletromagnetismo clássico. Esta necessidade de unir a relatividade e a mecânica quântica foi a segunda maior motivação no desenvolvimento da teoria quântica de campos. Pascual Jordan e Wolfgang Pauli mostraram em 1928 que os campos quânticos poderiam ser feitos para se comportar da maneira prevista pela teoria da relatividade especial. Um aumento adicional da teoria quântica veio com a descoberta da equação de Dirac, que foi originalmente formulada e interpretada como uma equação de uma única partícula análoga à equação de Schrodinger, mas ao contrário da equação de Schrodinger, a equação de Dirac satisfaz tanto a invariância de Lorentz, que é, um dos requisitos da relatividade restrital e as regras da mecânica quântica. A equação de Dirac descreveu o valor do spin como 1/2 do elétron e representaram seu momento magnético, bem como dando previsões precisas para os espectros de hidrogénio. A tentativa de interpretação da equação de Dirac como uma equação de uma única partícula não pôde ser mantida por muito tempo, no entanto, e, finalmente, foi mostrado que várias das suas propriedades indesejáveis (tais como estados de energia negativa) podem ser feitas por sentido de reformular e reinterpretar a equação de Dirac como uma equação de campo de verdade, neste caso, para a quantização "mar de Dirac" ou o "campo de elétrons", com as "soluções de energia negativa" que apontaram para a existência da Antimatéria.

Eletrodinâmica quântica

[editar | editar código-fonte]A Teoria da Eletrodinâmica Quântica teve seu início com Paul Dirac na década de 1920.[108]

Nos anos seguintes, com contribuições de Wolfgang Pauli, Eugene Wigner, Pascual Jordan, Werner Heisenberg e uma formulação elegante da eletrodinâmica quântica devido a Enrico Fermi,[109] os físicos passaram a acreditar que, em princípio, seria possível a realização de qualquer cálculo para qualquer processo físico envolvendo fótons e partículas carregadas. Dificuldades com a Teoria aumentaram até o último de 1940. Com Melhorias na Tecnologia de micro-ondas, foram possíveis fazer mais medições precisas da mudança dos níveis de um átomo de hidrogênio. Mesmo assim ainda a QED inicial apresentava problemas, até que Sin-Itiro Tomonaga,Julian Schwinger, Richard Feynman e Freeman Dyson criaram a definitiva teoria da eletrodinâmica quântica pela qual apenas Sin-Itiro Tomonaga, Feynman e Schwinger foram laureados com o nobel em 1965, Freeman Dyson não foi reconhecido.[110] QED serviu de modelo para todas as teorias quânticas de campo subseqüentes. Tal como teoria a cromodinâmica quântica, que começou na década de 1960 e atingiu sua forma atual em 1975 o trabalho de H. David Politzer, David Gross e, principalmente, de Frank Wilczek.

Cromodinâmica quântica

[editar | editar código-fonte]Em física teórica, cromodinâmica quântica (QCD) é uma teoria da interação forte (força de cor), a força fundamental que descreve as interações entre quarks e glúons que formam hádrons (como o próton, nêutron ou pion). É o estudo da teoria de Yang-Mills de férmions de cor carregada (os quarks). Com a invenção das câmaras de bolha e câmaras de ignição na década de 1950, a Física Experimental de Partículas descobriu um número grande e crescente de partículas chamadas hádrons. Pareciam ser um número tão grande de partículas que não poderiam ser fundamentais. Em primeiro lugar, as partículas foram classificados por carga e spin por Werner Heisenberg, então, em 1953, de acordo com estranheza por Murray Gell-Mann e Kazuhiko Nishijima. Para obter um maior conhecimento, os hádrons foram classificados em grupos com propriedades e massas semelhantes usando o caminho óctuplo, inventado em 1961 por Gell-Mann e Yuval Ne'eman. Gell-Mann e George Zweig, corrigindo uma abordagem anterior do Shoichi Sakata, passaram a propor em 1963 que a estrutura dos grupos pode ser explicada pela existência de três tipos de pequenas partículas no interior dos hádrons: os quarks.

A descoberta da liberdade assintótica nas interações fortes por David Gross, David Politzer e Frank Wilczek têm permitido físicos fazer previsões precisas dos resultados de muitos experimentos de alta energia utilizando a técnica de teoria quântica de campos de teoria de perturbação. Evidência de glúons foram descobertas em três eventos de colisão em PETRA em 1979. Estas experiências tornaram-se mais e mais precisas, culminando na verificação da QCD (cromodinâmica quântica) no CERN.

Teoria eletrofraca

[editar | editar código-fonte]Na física de partículas, a força eletrofraca é a descrição unificada de duas das quatro interações fundamentais conhecidas da natureza: o eletromagnetismo e da força nuclear fraca. Embora essas duas forças apareçam muito diferentes em baixas escalas de energias, a teoria modelou-as como dois aspectos diferentes de uma mesma força. Acima da energia de unificação, na ordem de 100 GeV (Giga ElectronVolts), elas se fundem em uma única força eletrofraca. Assim, se o universo é quente o suficiente (cerca de 1015 K, a temperatura ultrapassada até pouco depois do Big Bang), então a força eletromagnética e a força fraca irão se fundir em uma força eletrofraca combinada.

A história da unificação dessas duas forças começa com trabalhos de um jovem físico paquistanês chamado Abdus Salam. Salam trabalhou na teoria do neutrino, uma partícula elusiva que foi postulada pela primeira vez por Wolfgang Pauli em 1930. Salam apresentou a simetria quiral na teoria dos neutrinos.[111] A introdução da simetria quiral desempenhou papel crucial no desenvolvimento posterior da teoria da interação eletrofraca.[111] Salam mais tarde passou a trabalhar para Riazuddin, que fez contribuições pioneiras sobre neutrinos. Em 1960, Salam realizou um trabalho de física nuclear, onde foi pioneiro no trabalho de decaimento do próton. Salam introduziu a indução dos maciços bósons de Higgs na teoria do Modelo Padrão, onde ele previu a forma hipotética de decaimento radioativo emitido por prótons, portanto, ele teorizou a existência de decaimento do próton. Em 1963, Salam publicou seu trabalho teórico sobre o vetor méson.[112] O jornal apresentou a interação do vetor méson, fóton (vetor eletrodinâmico), e a renormalização de massa conhecida do vetor méson depois da interação. Em 1961, Salam começou a trabalhar com John Clive Ward em simetrias e unificação da força eletrofraca.[113][114]

Em 1964, Salam e Ward trabalharam em uma teoria de gauge (calibre) para a interação fraca e eletromagnética. O trabalho foi interrompido e, em seguida, continuou em 1959, Salam estava profundamente convencido de que todas as interações das partículas elementares são realmente as interações calibres. Em 1968, em conjunto com Steven Weinberg e Sheldon Glashow, Salam formulou o conceito matemático do seu trabalho. Em 1960, Salam e Weinberg incorporaram o mecanismo de Higgs, a descoberta de Glashow, dando a ele uma forma moderna na teoria eletrofraca, assim, a teoria do Modelo Padrão de Partículas.[115]

Em 1969 um jovem físico graduando em Den Helder na Holanda chamado Gerard 't Hooft deu continuidade ao trabalho de Salam sobre as interações electrofracas. Junto com seu professor de doutorado Martinus Veltman começou em seu doutorado. Ele iria trabalhar sobre o mesmo assunto que Veltman estava trabalhando, a renormalização das teorias de Yang-Mills. Em 1971, seu primeiro trabalho foi publicado.[116] Nele, ele mostrou como renormalizar campos de Yang-Mills sem massa, e foi capaz de derivar relações entre amplitudes. O mundo deu pouca atenção, mas Veltman ficou animado, porque ele viu que o problema que ele estava trabalhando fora resolvido. Um período de intensa colaboração seguindo do desenvolvimento da técnica de regularização dimensional. Logo em seguida o segundo trabalho de t'Hooft estava pronto para ser publicado,[117] em que ele mostrou que as teorias de Yang-Mills com campos enormes, poderiam ser renormalizados devido à quebra espontânea de simetria. Esse trabalho lhe valeu o reconhecimento mundial, e acabaria por ganhar o par do Prêmio Nobel de Física de 1999 junto com Veltman.

Física nuclear

[editar | editar código-fonte]